Kombiniertes transformations-basiertes Lernen erweiterter Chunks

|

|

|

- Karlheinz Falk

- vor 6 Jahren

- Abrufe

Transkript

1 Kombiniertes transformations-basiertes Lernen erweiterter Chunks Markus Dreyer Institut für Computerlinguistik Ruprecht-Karls-Universität Heidelberg Abstract Chunking beschränkt sich meist auf das Finden einfacher nicht-rekursiver Phrasen, sogenannter Basis- Phrasen. Im Gegensatz dazu wird hier ein erweiterter Chunking-Ansatz vorgestellt: Ein transformations-basiertes Lernsystem wird auf das Finden größerer nichtüberlappender Wortgruppen trainiert, die den grammatischen Relationen wie Subjekt und Objekten entsprechen. Diese erweiterten Chunks sind länger, heterogener und weniger leicht lernbar. Daher werden Erweiterungen des transformations-basierten Lernverfahrens getestet, die größere Flexibilität und linguistische Adäquatheit sichern sollen. Insbesondere wird eine Kombination handgeschriebener und maschinell gelernter Regeln vorgestellt. 1 Einleitung Chunking ist ein beliebtes Verfahren zur syntaktischen Annotation von Texten, denn im Gegensatz zum vollen hierarchischen Satz-Parsing ist es schnell und robust. Es existieren effiziente Methoden, um einzelne nicht-überlappende Wortgruppen ohne innere Struktur Chunks in Sätzen zu markieren. Allerdings sind die üblicherweise verwendeten Chunks sehr kleine Wortgruppen, die nur ein Inhaltswort und die evtl. davor stehenden Funktionswörter beinhalten. In folgendem Satz würden daher nach traditionellem Chunk-Konzept fünf Chunks markiert: [ Die Verbreitung ] [ des frühen Christentums ] [ im römischen Reich ] [ bezeugen ] [ zahlreiche archäologische Funde ]. 1 Die Einheit der Phrase die Verbreitung des frühen Christentums im römischen Reich als Akkusativ-Objekt geht verloren. In vielen Anwendungen sind solche größeren Einheiten aber gefordert, im Information Retrieval beispielsweise oder in Text-to-Speech Systemen. Bei der Synthetisierung gesprochener Sprache ist es sinnvoll, größere syntaktische Einheiten zu betrachten, wenn aufbauend auf syntaktischer Analyse prosodische Merkmale 1 Bei (Erik F. Tjong Kim Sang and Buchholz, 2000) bildet die Präposition einen eigenen Chunk, so dass in diesem Beispiel sogar von sechs Chunks auszugehen wäre. generiert werden sollen: Ein Nachrichtensprecher würde nach Reich eine Pause machen, sehr unwahrscheinlich wäre dagegen eine Sprechpause schon nach Verbreitung. Er belässt das gesamte Akkusativ-Objekt als Einheit. 2 Wir haben daher ein Korpus mit erweiterten Chunks annotiert, die größere, aber damit auch heterogenere Wortgruppen darstellen. Ein transformations-basiertes Lernverfahren wurde auf solche Chunks trainiert. Da die Lernaufgabe durch die Heterogenität der hier zu lernenden Chunks schwieriger als beim herkömmlichen Chunking zu bewältigen ist, wurden Erweiterungen des Lernalgorithmus getestet, die größere Flexibilität und linguistische Adäquatheit des Lernprozesses sichern sollen. Der folgende Abschnitt stellt dar, welche Arten von Chunks zugrunde gelegt wurden und wie das Korpus annotiert wurde. Abschnitt 3 erklärt das transformationsbasierte Lernverfahren, das zum Lernen solcher Chunks eingesetzt wurde. In Abschnitt 4 werden die durchgeführten Tests dargelegt, insbesondere das Testen einer Kombination von handgeschriebenen und maschinell gelernten Regeln. Die Abschnitte 5 und 6 stellen schließlich den Bezug zu verwandten Arbeiten her und präsentieren einige abschließende Bemerkungen. 2 Annotation der Daten 2.1 Erweiterte Chunks Die Chunks, die den hier vorgestellten Tests zugrunde liegen, orientieren sich an den grammatischen Relationen wie Subjekt, Objekten, Prädikat und Adverbialien. Solche größeren Einheiten werden jeweils als Wortgruppen im Korpus markiert: [ die Verbreitung des frühen Christentums im römischen Reich ] oder [ das vor der Garage geparkte Auto ]. Auch verbale und adjektivische Einheiten werden, basierend auf den zugrunde liegenden grammatischen Relationen, im Korpus als erweiterte Chunks markiert. Die grammatischen Termini Subjekt, Objekt etc. werden nicht im Korpus vermerkt und trainiert, vielmehr wird gekennzeichnet, ob es sich um nominale/präpositionale, um verbale oder adjektivisch/adver- 2 Evidenz dafür, dass grammatische Relationen wie Subjekt und Objekte Grundlage für die Prosodie sind, liefern beispielsweise (Bachenko and Fitzpatrick, 1986): Komplexe Strukturen wie the destruction of the good name of his father bilden eine prosodische Einheit (S. 149).

2 biale Wortgruppen handelt, wie in folgendem Beispiel: 3 [ AP Seit langem ] [ VP verschreibt sich ] [ NP Schrempf ] [ NP der Nachwuchsförderung im Bereich Management ]. Diese markierten Wortgruppen entsprechen einer Adverbiale, dem Prädikat, dem Subjekt und dem Dativ-Objekt. Sie können als Chunks im Sinne von nicht-überlappenden Wortgruppen ohne innere Struktur bezeichnet werden. Sie nähern sich durch die Ausweitung auf größere Wortgruppen den im Partial Parsing markierten Teilstrukturen des Satzes an, ähneln aber den Chunks im ursprünglichen Sinne, da sie nicht hierarchisch und jeweils ohne eine innere Struktur annotiert werden. Sie sollen als erweiterte Chunks bezeichnet werden und mit Chunking- Methoden in Texten gefunden werden. Bei im Text nicht zusammenhängenden Relationen wurden nur die zusammenhängenden Teile berücksichtigt. Einzeln übrigbleibende Worte wurden als zu keinem Chunk gehörig markiert: 4 [ AP Seit langem ] [ VP hat sich ] [ NP Schrempf ] [ NP der Nachwuchsförderung im Bereich Management ] verschrieben. Enthält eine grammatische Relation einen durch Komma abgetrennten Satz oder eine Apposition, wurden diese abgetrennt und eigenständig analysiert. Folgendes Beispiel, das als Gesamtheit ein Subjekt oder Akkusativ-Objekt ist, wurde daher nicht als ein einziger Chunk angesehen: [ NP die Lieferung der Ware ], [ NP die ] [ AP erst gestern ] [ VP eingetroffen war ] 2.2 Korpus und Baseline-Ergebnis Für das Trainieren und Testen des Systems standen 1100 Sätze (ca Wörter) aus deutschen Zeitungstexten zur Verfügung. Es handelt sich damit um ein kleines Korpus, verglichen mit dem Korpus von über Wörtern, das (Ramshaw and Marcus, 1995) zur Verfügung stand. Die einzelnen Wörter wurden mit POS-Tags (siehe (Schiller et al., 1995)) und Chunk-Tags versehen. Die Chunk-Tags setzen sich aus den in (Ramshaw and Marcus, 1995) beschriebenen Kennzeichen I, B und O zusammen sowie aus den Chunktyp-Bezeichnern NP, VP und AP. Für Bestandteile, die keiner Phrase zugeordnet wurden, wurde XX verwendet. I bedeutet innerhalb einer Phrase, B Grenze zur gleichnamigen linken Phrase, und O heißt außerhalb einer Phrase. Der Satz [ AP Schon lange ] [ VP hat sich ] [ NP Schrempf ] [ NP der Nachwuchsförderung im Bereich Management ] verschrieben. sieht annotiert so aus: 3 vgl. NP, VP und ADVP/ADJP in (Erik F. Tjong Kim Sang and Buchholz, 2000). 4 Der vorgestellte Chunker entstand im Zusammenhang mit einem Text-to-Speech System, wo es auf größere Satzeinheiten ankommt. Nur für nominale/präpositionale Phrasen wurden einzelne Wörter zugelassen. Schon/ADV/I-AP lange/adv/i-ap hat/vafin/i-vp sich/prf/i-vp Schrempf/NE/I-NP der/art/b-np Nachwuchsförderung/NN/I-NP im/ APPRART/I-NP Bereich/NN/I-NP Management/NN/I-NP verschrieben/vvpp/o-xx./$./o-xx Die hier durchgeführte Art der Annotation stellt eine anspruchsvolle Lernaufgabe dar, da gleichnamige Chunks höchst unterschiedlich aussehen können. Als NP ergeben sich gleichermaßen Konstrukte wie (1) Schrempf, (2) der Nachwuchsförderung im Bereich Management, oder (3) die Lieferung der Ware. Das Lernverfahren muss gewissermaßen Basis-Chunking, Präpositionalphrasen-Attachment und Attribut-Attachment lernen. Die Schwierigkeit einer Annotations-Aufgabe kann man daran abschätzen, wie erfolgreich schon einfachste Heuristiken arbeiten. Eine sehr einfache Heuristik (Standard-Baseline-Heuristik) ist es, jedem POS-Tag einfach dasjenige Chunk-Tag zuzuordnen, das diesem POS-Tag im Korpus insgesamt am häufigsten zugeordnet wurde. Jedem Nomen (NN) beispielsweise wird also das Chunk-Tag I-NP zugeordnet, obwohl Nomen im manuell annotierten Korpus teils auch mit B-NP versehen sind. Prinzipiell gilt: Wenn eine dermaßen simple Methode, angewendet auf das zur Verfügung stehende Korpus, schon sehr erfolgreich arbeitet, kann die Annotationsaufgabe so schwer nicht sein. Das hier benutzte annotierte Korpus weist ein Baseline-Ergebnis von nur = 63,33 auf. 5 Zum Vergleich: Die Chunking-Aufgabe aus (Erik F. Tjong Kim Sang and Buchholz, 2000) legt Daten mit einem Baseline-Ergebnis von = 77,07 zugrunde. Die hier vorliegende Chunking-Aufgabe ist also, durch die Heterogenität der erweiterten Chunks, wesentlich komplexer. Das im Folgenden dargestellte Lernverfahren wurde auf das Finden solcher Chunks trainiert. 3 Das transformations-basierte Lernverfahren Das transformations-basierte Lernen wurde von (Brill, 1992) eingeführt, zunächst um POS-Tagging regelbasiert durchführen zu können. (Ramshaw and Marcus, 1995) haben den Ansatz an das Chunking-Problem angepasst. Diesen Ansatz haben wir implementiert und eingesetzt. Er ist besonders geeignet, komplexe Zusammenhänge zwischen Wörtern, POS-Tags und Chunk-Tags zu lernen, da hier die Möglichkeit besteht, große lokale Kontexte zu betrachten und da es, wie in 4.2 gezeigt werden soll, mit handkodiertem linguistischen Wissen kombiniert werden kann. 5 Der -Wert wird aus Precision und Recall berechnet. Diese und die folgenden Werte gehen von =1 aus, vgl. (Erik F. Tjong Kim Sang and Buchholz, 2000).

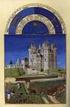

3 3.1 Der Algorithmus Der Algorithmus soll hier kurz beschrieben werden. 6 In der Lernphase werden zwei Korpora eingelesen: das korrekt annotierte Trainingskorpus und der Initial State. Diese enthalten beide den gleichen Text, wurden aber vor dem Lernprozess auf unterschiedliche Weisen annotiert, d.h. mit Chunk-Tags versehen: Das korrekt annotierte Trainingskorpus besteht in unserem Falle aus 90% der zur Verfügung stehenden Sätze (inklusive POS-Tags), die von Hand mit Chunk-Tags annotiert wurden. Der Initial State besteht aus den gleichen Sätzen, die Chunk- Tags aber werden hier nur durch eine einfache Heuristik zugewiesen (Baseline-Heuristik, siehe oben), sind also teils fehlerhaft. Die Lernphase selbst besteht in einem Kreislauf (siehe Abbildung 1): Der Algorithmus vergleicht in jedem Durchlauf den fehlerhaft heuristisch getaggten mit dem korrekt per Hand getaggten Korpus und generiert Transformationsregeln, deren Anwendung jeweils die Anzahl der Fehler im Initial State verringert würde. Die beste dieser generierten Regeln wird anhand einer Bewertungsfunktion ausgewählt und auf den Initial State angewendet. Der Kreislauf des Generierens, Evaluierens und Anwendens von Regeln setzt sich solange fort, bis keine Regel mehr gefunden werden kann, die den Initial State weiter signifikant verbessert. Welche Verbesserungen tatsächlich noch als signifikant gelten und welche nur noch als bedeutungslose minimale Änderungen anzusehen sind, legt ein einstellbarer Threshold-Wert fest, der bei unseren Experimenten so niedrig wie möglich gesetzt wurde. Wird in einem Durchlauf der Threshold- Wert auch von der besten generierten Regel nicht mehr überschritten, stoppt der Lernprozess. Alle bis dahin angewendeten Regeln bilden als geordnete Folge das gelernte Regelwerk. Eine automatisch generierte Regel könnte zum Beispiel lauten: Wandle das Chunk-Tag c i eines Wortes w i immer dort in B-NP um, wo das vorhergehende Wort w i-1 mit dem POS-Tag Eigenname (NE) und das nachfolgende Wort w i+1 mit dem Chunk-Tag I-NP versehen ist. Solche Regeln sind immer Instantiierungen vorgegebener Regel-Templates, die lokale Kontexte definieren beispielweise den eben erwähnten Kontext POS-Tag t i-1 des vorhergehenden Worts w i-1 und Chunk-Tag c i+1 des nachfolgenden Worts w i+1. Die in (Ramshaw and Marcus, 1995) dargestellten Templates, die bis zu drei Positionen links und drei Positionen rechts vom jeweils aktuellen Wort w i betrachten, wurden übernommen. 3.2 Veränderte Anwendung von Regeltemplates Der transformations-basierte Algorithmus hat sich als hartnäckig gegenüber denkbaren Erweiterungen erwiesen. So wird in (Ramshaw and Marcus, 1994) mit veränderten Bewertungsfunktionen für generierte Regeln experimentiert. Die Experimente führten zu keiner Verbes- 6 Für eine ausführliche Beschreibung des transformations-basierten Lernens siehe u.a. (Brill, 1992; Brill, 1993). serung des Lernverhaltens. Bei den hier vorzustellenden Tests wurde mit veränderten Anwendungen der Kontexte experimentiert, die in den Templates definiert sind: So wurde der Kontext POS-Tag t i-1 des vorhergehenden Worts w i-1 und Chunk-Tag c i+1 des nachfolgenden Worts w i+1 beispielsweise auch auf Positionen im Korpus angewendet, bei denen das Chunk-Tag c i+1 mit einer bestimmten Zeichenfolge beginnt oder auf eine bestimmte Zeichenfolge endet. Daher konnten flexiblere Regeln gebildet werden, wie etwa: Wandle das Chunk-Tag c i eines Wortes w i immer dort in B-NP um, wo das vorhergehende Wort w i-1 mit dem POS-Tag Eigenname (NE) und mit einem Chunk-Tag c i-1 versehen ist, das auf NP endet. Bei einer solchen Regel macht es keinen Unterschied, ob das vorhergehende Wort das Chunk-Tag B-NP oder I- NP trägt. Beide markieren ja gleichermaßen die Zugehörigkeit zu einer NP. Solche erweiterten Instantiierungen der durch die Regeltemplates festgelegten Kontexte führten aber zu keiner Verbesserung der Lern-Ergebnisse. Im Zusammenhang mit den Regeltemplates wären weitere Änderungen vorstellbar, die allerdings im Rahmen der vorgestellten Arbeit nicht durchgeführt werden konnten: Nicht nur die links und rechts stehenden Wörter und Tags, sondern auch das generelle Vorhandensein bestimmter Verben oder Elemente bestimmter Verbklassen im Satz könnten Chunk-Änderungen auslösen. Auf diese Weise könnten Valenzaspekte in den Lernvorgang mit einfließen. Eine andere Modifikation, die sich in den durchgeführten Tests erfolgreich bewährt hat, soll im folgenden Abschnitt vorgestellt werden: Eine radikale Änderung der Baseline-Heuristik hat eine Verbesserung der Lern-Ergebnisse bewirkt. 4 Tests und Ergebnisse 4.1 Standard-Baseline-Heuristik Wendet man die oben (siehe Abschnitt 2.2) beschriebene Standard-Methode als Baseline-Heuristik an, so ergibt sich ein Ausgangszustand (Initial State) für den Lernalgorithmus, der eine Precision von 69,27% und einen Recall von 58,33% aufweist ( -Wert 63,33). Ausgehend von diesem Ausgangszustand lernte der Algorithmus 75 Regeln und annotierte anschließend das Test- Korpus mit dem verbesserten -Wert von 78,42 (Precision/Recall: 81,02%/75,99%). Alle angegebenen Werte sind Mittelwerte aus drei Testdurchläufen, mit jeweils unterschiedlicher zufälliger Aufteilung der 1100 Sätze in 90% Trainings- und 10% Testset. Bei jedem Testdurchlauf bestand das Trainingsset also aus knapp 1000 Sätzen, d.h. ca Wörtern. 4.2 Reguläre Grammatik als Baseline-Heuristik Mit den drei gleichen Aufteilungen in Trainings- und Testset wurden anschließend die Tests wiederholt, wobei

4 Einfache heuristische Annotation Nicht annotierter Text Sorgfältige manuelle Annotation Fehlerhafter Initial State Überprüfung Lerner Korrekt getaggtes Trainingskorpus Regel anwendung Transformations regel Regel generierung Gelernte Regeln Abbildung 1: Transformations-basiertes Lernen. Ein heuristisch getaggter Text (Initial State) und ein korrekt getaggter Text dienen als Datenbasis. Durch Anwendung generierter Transformations-Regeln wird der heuristisch getaggte dem korrekt getaggten Text nach und nach angepasst. Bei den hier vorgestellten Experimenten wird die initiale heuristische Annotation gegen eine regelhafte Annotation ausgetauscht. die Standard-Baseline-Heuristik durch eine andere Methode ersetzt wurde: Der Initial State wurde nun durch Anwendung einer einfachen handgeschriebenen Grammatik gebildet, die mit regulären Ausdrücken arbeitet. Hier wurden auf der Basis der POS-Tags kleinere Chunks bzw. Teile von Chunks durch Finite-State-Methoden zusammengefasst, die leicht als solche zu erkennen sind, wie etwa Schrempf oder der Nachwuchsförderung oder im Bereich. Auch Adjektive und Adverbialien wurden in solche NPs hineingenommen, etwa der lange erwartete Regen, oder sie wurden als eigene APs vorannotiert: schon lange. Ebenso wurden einfache Verb- Komplexe wie vermutet hatte gefunden und im Initial State markiert. Das Chunking der Basis-Phrasen wurde somit ansatzweise durch eine reguläre Grammatik erledigt, die auf der Ebene der POS-Tags Chunks bildet. 7 Dieser Ausgangszustand allein wird mit Precision/Recall 59,52%/73,08% ( =65,61) evaluiert und liegt damit noch immer deutlich unter dem Baseline-Ergebnis von =77,07, mit dem die Daten aus (Erik F. Tjong Kim Sang and Buchholz, 2000) evaluiert werden. Der Lernaufwand wird durch Anwendung einer intelligenteren Baseline-Heuristik begrenzt. Dem transformations-basierten Lernalgorithmus bleibt aber die Aufgabe des Lernens von Erweiterungen einzelner Chunks und des Linkings mehrerer benachbarter Chunks, wie etwa der drei kleinen Basis-Phrasen [ der Nachwuchsförderung ] [ im Bereich ] [ Managment ], die zu einem erweiterten Chunk zusammengefügt werden müssen: [ der Nachwuchsförderung im Bereich Managment ]. Ebenso werden einzelne Chunks neu gelernt, die von den handgeschriebenen Regeln nicht erfasst wurden. Der 7 Eine ausführliche Beschreibung dieser Grammatik findet sich in (Dreyer, 2002, Kapitel 3.2). Algorithmus lernte in der Lernphase 55 Regeln. Die reguläre Grammatik und die darauf aufbauend maschinell gelernten Regeln brachten es im Test auf ein Ergebnis von = 80,58 (Precision/Recall: 82,71%/78,54%). Der Einsatz der handgeschriebenen regulären Grammatik bewirkte also ein verbessertes Lern-Ergebnis. Der Wert liegt noch immer unter dem Evaluationswert anderer Chunking-Systeme, die gestellte Aufgabe ist aber auch entsprechend schwerer, denn die zu lernenden erweiterten Chunks sind länger und weitaus heterogener als einfache Chunks. Initial State Baseline-Erg. Lern-Erg. Standard-Baseline 63,33 78,42 Reguläre Grammatik 65,61 80,58 Tabelle 1: Baseline- und Lern-Ergebnisse. Eine handkodierte reguläre Grammatik zur Annotation des Initial State bewirkte ein verbessertes Lern-Ergebnis. Die Zahlen sind -Werte. 5 Unterschiede zu verwandten Arbeiten Der hier vorgestellte Ansatz geht über den Chunking- Ansatz von (Ramshaw and Marcus, 1995) hinaus, da er nicht Basis-Chunks, sondern erweiterte, komplexere Chunks markiert. Damit wird er vergleichbar mit Partial-Parsing-Systemen und kaskadierten Chunkern, die die gefundenen Basis-Chunks nachträglich zu größeren Einheiten zusammenfassen. (Abney, 1996) beschreibt einen Parser, der in mehreren Schritten kleine Wortgruppen zu größeren zusammenfügt. Kaskadierte Finite- State-Transduktoren sind hintereinander geschaltet; jeder Transduktor arbeitet auf dem Output des vorherge-

5 henden Transduktors und verbindet die von diesem gefundenen Strukturen zu größeren Einheiten. So entstehen, angefangen von Basis-Chunks, Schritt für Schritt größere hierarchische Satzstrukturen. Auch FASTUS, ein System zur Informationsextraktion, hat vergleichbare Module als Bestandteile. Ein erstes Modul findet so genannte Basis-Phrasen, und ein zweites fügt diese dann anhand von Heuristiken zu komplexen Phrasen zusammen (Hobbs et al., 1997, S ). Unterlaufen schon beim Finden der Basis-Phrasen Fehler, so setzen sich diese beim anschließenden Attachment fort. Sowohl Abneys kaskadierter Finite-State-Parser als auch FASTUS arbeiten ausschließlich mit handgeschriebenen Regeln. Ein menschlicher Grammatikschreiber muss einerseits Regeln schreiben, die Basis-Phrasen definieren und andererseits solche, die das Zusammenfügen benachbarter Basis-Phrasen zu größeren Einheiten steuern. Diese beiden Prozesse werden streng voneinander getrennt. Das kombinierte transformations-basierte Chunking, das hier vorgestellt wurde, arbeitet dagegen nicht mit rein handgeschriebenen Regeln und geht das Finden erweiterter Chunks ergebnisorientiert an: Wichtig ist hier nicht die Hierarchisierung des Basis-Chunking und anschließenden Attachments, sondern das Zusammenspiel handgeschriebener und maschinell gelernter Regeln, durch das erweiterte Chunks als nicht-hierarchische Wortgruppen gefunden werden. Die handgeschriebenen Regeln finden die Chunks oder Chunkteile, die eindeutig und leicht zu beschreiben sind. Die maschinell gelernten Regeln übernehmen alle weiteren Anpassungen an den Endzustand erweiterter Chunks, sei es das Attachment benachbarter Chunkteile oder auch das Finden neuer Chunks, die vollständig von der handkodierten Regelmenge vernachlässigt wurden. Fehler oder Unterlassungen, die den handgeschriebenen Regeln zuzurechnen sind, werden idealerweise von den maschinell gelernten Regeln korrigiert und umgekehrt werden Wortgruppen, die als solche aus dem gegebenen Korpus maschinell nicht zuverlässig gelernt werden können, durch die handgeschriebenen Regeln abgedeckt. 6 Fazit Das transformations-basierte Lernverfahren wurde angewendet, um korpusbasiert das Finden und Markieren größerer syntaktischer Einheiten zu lernen. Die gelernten Einheiten entsprechen nicht den üblicherweise beim Chunking verwendeten Basis-Chunks, sondern mit Einschränkungen den grammatischen Relationen der Sätze. Hierfür wurde der Begriff der erweiterten Chunks benutzt, da sich das Verfahren als Chunking-Verfahren vom hierarchischen Partial-Parsing unterscheidet, das mit Basis-Phrasen und deren anschließenden hierarchischen Verbindungen arbeitet. Für die Lernaufgabe wurde das Chunking aus (Ramshaw and Marcus, 1995) umgesetzt, wobei unterschiedliche Baseline-Heuristiken angewendet wurden. Bei Einsatz einer handgeschriebenen regulären Grammatik als Baseline-Heuristik wurde ein besseres Lern-Ergebnis erzielt als bei Einsatz der Standard-Baseline-Heuristik, die nach dem Prinzip der maximalen Häufigkeit verfährt. Die handgeschriebene Grammatik wurde gewissermaßen automatisch durch den Lernalgorithmus fortgeschrieben. Dies ist ein theoretisch interessanter Aspekt, da so linguistisches Wissen durch einen menschlichen Experten vorgegeben und durch das Lernverfahren vervollständigt wird. Grundsätzlich können in einer solchen Initial-State-Grammatik alle denkbaren Regelhaftigkeiten vorgegeben werden, von denen angenommen wird, dass sie im automatischen Lernprozess nicht gefunden werden. Die linguistische Adäquatheit der resultierenden Lern-Ergebnisse kann so gesteigert werden. Das transformations-basierte Lernen eignet sich besonders gut für diese Kombination aus menschlicher und maschineller Grammatikschreibung, da die Vorgabe eines Ausgangszustandes im Gegensatz zum Chunking etwa mit Markov-Modellen bereits integraler Bestandteil des Lern- und Chunking- Algorithmus selbst ist. Zu untersuchen bleibt, inwieweit sich dieses kombinierte Verfahren eignet, um zuverlässig das Chunking unterschiedlicher Textsorten oder Domänen zu lernen: Invariante linguistische Grundzusammenhänge könnten durch die handkodierte Baseline-Annotation vorgegeben werden, so dass der Lerner nur noch die spezifischen syntaktischen und lexikalischen Eigenheiten dazulernen muss. References Steven P. Abney Partial parsing via finite-state cascades. In Workshop on Robust Parsing, 8th European Summer School in Logic, Language and Information, pages 8 15, Prag. J. Bachenko and E. Fitzpatrick The contribution of parsing to prosodic phrasing in an experimental text-to-speech system. In Proceedings of the ACL, pages Eric Brill A simple rule-based part-of-speech tagger. In Proceedings of ANLP-92, 3rd Conference on Applied Natural Language Processing, pages , Trento, IT. Eric Brill A Corpus-Based Approach to Language Learning. Ph.D. thesis, University of Pennsylvania, Philadelphia, USA, Dezember. Markus Dreyer Syntaktisches Parsing zur prosodischen Merkmalsgenerierung. Magisterarbeit, Universität Heidelberg, Februar. Erik F. Tjong Kim Sang and Sabine Buchholz Introduction to the CoNLL-2000 shared task: Chunking. In Proceedings of CoNLL-2000 and LLL Jerry R. Hobbs, Douglas Appelt, John Bear, David Israel, Megumi Kameyama, Mark E. Stickel, and Mabry Tyson FASTUS: A cascaded finite-state transducer for extracting information from natural-language text. In Emmanuel Roche and Yves Schabes, edi-

6 tors, Finite-State Devices for Natural Language Processing, pages MIT Press, Cambridge, MA. Lance A. Ramshaw and Mitchell P. Marcus Exploring the statistical derivation of transformational rule sequences for part-of-speech tagging. In The Balancing Act: Proceedings of the ACL Workshop on Combining Symbolic and Statistical Approaches to Language. New Mexico State University, July. Lance A. Ramshaw and Mitchell P. Marcus Text chunking using transformation-based learning. In Proceedings of the Third Annual Workshop on Very Large Corpora, pages ACL. A. Schiller, S. Teufel, and C. Thielen Guidelines für das Tagging deutscher Textkorpora mit STTS. Technical report, Universität Stuttgart und Universität Tübingen, September.

Informationsextraktion. Karin Haenelt 1.12.2012

Informationsextraktion Karin Haenelt 1.12.2012 Informationsextraktion Ziel Identifikation bestimmter Information (Daten) in einem unstrukturierten oder teilstrukturierten textuellen Dokument Transformation

Informationsextraktion Karin Haenelt 1.12.2012 Informationsextraktion Ziel Identifikation bestimmter Information (Daten) in einem unstrukturierten oder teilstrukturierten textuellen Dokument Transformation

1 Part-of-Speech Tagging

2. Übung zur Vorlesung NLP Analyse des Wissensrohstoes Text im Sommersemester 2008 Dr. Andreas Hotho, Dipl.-Inform. Dominik Benz, Wi.-Inf. Beate Krause 28. Mai 2008 1 Part-of-Speech Tagging 1.1 Grundlagen

2. Übung zur Vorlesung NLP Analyse des Wissensrohstoes Text im Sommersemester 2008 Dr. Andreas Hotho, Dipl.-Inform. Dominik Benz, Wi.-Inf. Beate Krause 28. Mai 2008 1 Part-of-Speech Tagging 1.1 Grundlagen

INFORMATIONSEXTRAKTION

INFORMATIONSEXTRAKTION Referentin: Syriane Kemayou Yamga Universität Heidelberg, Computerlinguistik, Hauptseminar: Information Retrieval PD. Dr. Karin Haenelt 16.01.2006 Informationsextraktion (IE) 1.

INFORMATIONSEXTRAKTION Referentin: Syriane Kemayou Yamga Universität Heidelberg, Computerlinguistik, Hauptseminar: Information Retrieval PD. Dr. Karin Haenelt 16.01.2006 Informationsextraktion (IE) 1.

Part-of-Speech Tagging. Stephanie Schuldes

Part-of-Speech Tagging Stephanie Schuldes 05.06.2003 PS Erschließen von großen Textmengen Geißler/Holler SoSe 2003 Motivation Ziel: vollständiges Parsing und Verstehen natürlicher Sprache Herantasten durch

Part-of-Speech Tagging Stephanie Schuldes 05.06.2003 PS Erschließen von großen Textmengen Geißler/Holler SoSe 2003 Motivation Ziel: vollständiges Parsing und Verstehen natürlicher Sprache Herantasten durch

Part of Speech Tagging. Linguistische Sicht. Carolin Deck

Part of Speech Tagging Linguistische Sicht Carolin Deck Gliederung 1. Begriffsklärung 2. Vorstellung zwei wichtiger Tagsets (STTS & PTTS) 3. Bedeutung des POS-Tagging für die Sprachwissenschaft 4. Tagzuweisung

Part of Speech Tagging Linguistische Sicht Carolin Deck Gliederung 1. Begriffsklärung 2. Vorstellung zwei wichtiger Tagsets (STTS & PTTS) 3. Bedeutung des POS-Tagging für die Sprachwissenschaft 4. Tagzuweisung

NLP Eigenschaften von Text

NLP Eigenschaften von Text Dr. Andreas Hotho Dominik Benz Beate Krause Sommersemester 2008 Folie: 1 Übersicht Einführung Eigenschaften von Text Words I: Satzgrenzenerkennung, Tokenization, Kollokationen

NLP Eigenschaften von Text Dr. Andreas Hotho Dominik Benz Beate Krause Sommersemester 2008 Folie: 1 Übersicht Einführung Eigenschaften von Text Words I: Satzgrenzenerkennung, Tokenization, Kollokationen

Syntax. Ending Khoerudin Deutschabteilung FPBS UPI

Syntax Ending Khoerudin Deutschabteilung FPBS UPI Traditionale Syntaxanalyse Was ist ein Satz? Syntax: ein System von Regeln, nach denen aus einem Grundinventar kleinerer Einheiten (Wörter und Wortgruppen)

Syntax Ending Khoerudin Deutschabteilung FPBS UPI Traditionale Syntaxanalyse Was ist ein Satz? Syntax: ein System von Regeln, nach denen aus einem Grundinventar kleinerer Einheiten (Wörter und Wortgruppen)

EXTRAKTION UND KLASSIFIKATION VON BEWERTETEN PRODUKTFEATURES AUF WEBSEITEN

EXTRAKTION UND KLASSIFIKATION VON BEWERTETEN PRODUKTFEATURES AUF WEBSEITEN T-SYSTEMS MULTIMEDIA SOLUTIONS GMBH, 16. FEBRUAR 2012 1. Schlüsselworte Semantic Web, Opinion Mining, Sentiment Analysis, Stimmungsanalyse,

EXTRAKTION UND KLASSIFIKATION VON BEWERTETEN PRODUKTFEATURES AUF WEBSEITEN T-SYSTEMS MULTIMEDIA SOLUTIONS GMBH, 16. FEBRUAR 2012 1. Schlüsselworte Semantic Web, Opinion Mining, Sentiment Analysis, Stimmungsanalyse,

Interdisziplinäre fachdidaktische Übung: Modelle für Sprachen in der Informatik. SS 2016: Grossmann, Jenko

Interdisziplinäre fachdidaktische Übung: Modelle für Sprachen in der SS 2016: Grossmann, Jenko Die Beschreibung orientiert sich am Begriffssystem der Beschreibung natürlicher Sprachen Sprache in der steht

Interdisziplinäre fachdidaktische Übung: Modelle für Sprachen in der SS 2016: Grossmann, Jenko Die Beschreibung orientiert sich am Begriffssystem der Beschreibung natürlicher Sprachen Sprache in der steht

Syntax - Das Berechnen syntaktischer Strukturen beim menschlichen Sprachverstehen (Fortsetzung)

Syntax - Das Berechnen syntaktischer Strukturen beim menschlichen Sprachverstehen (Fortsetzung) Markus Bader 9. Februar 2004 Inhaltsverzeichnis 4 Übertragung ins e 1 4.3 Bewegung und Satztyp................................

Syntax - Das Berechnen syntaktischer Strukturen beim menschlichen Sprachverstehen (Fortsetzung) Markus Bader 9. Februar 2004 Inhaltsverzeichnis 4 Übertragung ins e 1 4.3 Bewegung und Satztyp................................

Annotation des Wittgenstein-Korpus mit Wortart-Information

Annotation des Wittgenstein-Korpus mit Wortart-Information Institut für Informations- und Sprachverarbeitung Ludwig-Maximilian-Universität München schmid@cis.uni-muenchen.de Überblick Was ist Wortart-Tagging?

Annotation des Wittgenstein-Korpus mit Wortart-Information Institut für Informations- und Sprachverarbeitung Ludwig-Maximilian-Universität München schmid@cis.uni-muenchen.de Überblick Was ist Wortart-Tagging?

1. Stellen Sie die Konstituentenstruktur der folgenden Sätze als Baumdiagramme dar:

1. Stellen Sie die Konstituentenstruktur der folgenden Sätze als Baumdiagramme dar: 1. Die Überschwemmungen hinterließen ernorme Schäden. 2. Der amtierende Bundeskanzler verzichtet auf eine erneute Kandidatur.

1. Stellen Sie die Konstituentenstruktur der folgenden Sätze als Baumdiagramme dar: 1. Die Überschwemmungen hinterließen ernorme Schäden. 2. Der amtierende Bundeskanzler verzichtet auf eine erneute Kandidatur.

Part-of-Speech- Tagging

Part-of-Speech- Tagging In: Einführung in die Computerlinguistik Institut für Computerlinguistik Heinrich-Heine-Universität Düsseldorf WS 2004/05 Dozentin: Wiebke Petersen Tagging Was ist das? Tag (engl.):

Part-of-Speech- Tagging In: Einführung in die Computerlinguistik Institut für Computerlinguistik Heinrich-Heine-Universität Düsseldorf WS 2004/05 Dozentin: Wiebke Petersen Tagging Was ist das? Tag (engl.):

Informationsextraktion

Informationsextraktion Bestimmte Anwendungen bei der semantischen Verarbeitung erfordern keine tiefe linguistische Analyse mit exakter Disambiguierung (= eine einzige und korrekte Lesart). Hierzu gehört

Informationsextraktion Bestimmte Anwendungen bei der semantischen Verarbeitung erfordern keine tiefe linguistische Analyse mit exakter Disambiguierung (= eine einzige und korrekte Lesart). Hierzu gehört

Elementare Begriffe der Wahrscheinlichkeitstheorie für die Sprachverarbeitung

Elementare Begriffe der Wahrscheinlichkeitstheorie für die Sprachverarbeitung Kursfolien Karin Haenelt 1 Übersicht Wahrscheinlichkeitsfunktion P Wahrscheinlichkeit und bedingte Wahrscheinlichkeit Bayes-Formeln

Elementare Begriffe der Wahrscheinlichkeitstheorie für die Sprachverarbeitung Kursfolien Karin Haenelt 1 Übersicht Wahrscheinlichkeitsfunktion P Wahrscheinlichkeit und bedingte Wahrscheinlichkeit Bayes-Formeln

KI-Kolloquium am 23.10.2006. Part-of-Speech-Tagging für Deutsch. Referent: Stefan Bienk

Friedrich-Alexander-Universität Erlangen-Nürnberg Lehrstuhl für Informatik 8 (KI) Prof. Dr. H. Stoyan KI-Kolloquium am 23.10.2006 Part-of-Speech-Tagging für Deutsch Referent: Stefan Bienk Übersicht Aufgabenstellung

Friedrich-Alexander-Universität Erlangen-Nürnberg Lehrstuhl für Informatik 8 (KI) Prof. Dr. H. Stoyan KI-Kolloquium am 23.10.2006 Part-of-Speech-Tagging für Deutsch Referent: Stefan Bienk Übersicht Aufgabenstellung

Einführung in die Computerlinguistik

Einführung in die Computerlinguistik Statistische Modellierung Fragebogenaktion Bachelor-StudentInnen http://www.coli.uni-saarland.de/bsc/page.php?id=fragebogen WS 2013/2014 Andrea Horbach mit Folien von

Einführung in die Computerlinguistik Statistische Modellierung Fragebogenaktion Bachelor-StudentInnen http://www.coli.uni-saarland.de/bsc/page.php?id=fragebogen WS 2013/2014 Andrea Horbach mit Folien von

Einführung in die Computerlinguistik

Einführung in die Computerlinguistik Statistische Modellierung I WS 2010/2011 Manfred Pinkal Wortartinformation Wortartinformation ist eine wichtige Voraussetzung für die syntaktische Analyse. Woher kommt

Einführung in die Computerlinguistik Statistische Modellierung I WS 2010/2011 Manfred Pinkal Wortartinformation Wortartinformation ist eine wichtige Voraussetzung für die syntaktische Analyse. Woher kommt

Kapitel 2: Formale Sprachen Gliederung. 0. Grundbegriffe 1. Endliche Automaten 2. Formale Sprachen 3. Berechnungstheorie 4. Komplexitätstheorie

Gliederung 0. Grundbegriffe 1. Endliche Automaten 2. Formale Sprachen 3. Berechnungstheorie 4. Komplexitätstheorie 2.1. 2.2. Reguläre Sprachen 2.3. Kontextfreie Sprachen 2/1, Folie 1 2015 Prof. Steffen

Gliederung 0. Grundbegriffe 1. Endliche Automaten 2. Formale Sprachen 3. Berechnungstheorie 4. Komplexitätstheorie 2.1. 2.2. Reguläre Sprachen 2.3. Kontextfreie Sprachen 2/1, Folie 1 2015 Prof. Steffen

Bachelorarbeit Erkennung von Fließtext in PDF-Dokumenten

Bachelorarbeit Erkennung von Fließtext in PDF-Dokumenten 16.08.2016 David Spisla Albert Ludwigs Universität Freiburg Technische Fakultät Institut für Informatik Gliederung Motivation Schwierigkeiten bei

Bachelorarbeit Erkennung von Fließtext in PDF-Dokumenten 16.08.2016 David Spisla Albert Ludwigs Universität Freiburg Technische Fakultät Institut für Informatik Gliederung Motivation Schwierigkeiten bei

Fabian Heck Perlmutter & Soames Beethovenstr. 15, Raum Sommmersemester 2007

Transformationsgrammatik der 60er/70er Fabian Heck Perlmutter & Soames 1979 Institut für Linguistik Dienstag, 11h15-12h45 Universität Leipzig Beethovenstr. 15, Raum 1.516 Sommmersemester 2007 14. Regelordnungen

Transformationsgrammatik der 60er/70er Fabian Heck Perlmutter & Soames 1979 Institut für Linguistik Dienstag, 11h15-12h45 Universität Leipzig Beethovenstr. 15, Raum 1.516 Sommmersemester 2007 14. Regelordnungen

Swantje Westpfahl & Thomas Schmidt POS für(s) FOLK

Swantje Westpfahl & Thomas Schmidt POS für(s) FOLK Problemanalyse des POS- Taggings für spontansprachliche Daten anhand des Forschungsund Lehrkorpus Gesprochenes Deutsch 2 FOLK Forschungs- und Lehrkorpus

Swantje Westpfahl & Thomas Schmidt POS für(s) FOLK Problemanalyse des POS- Taggings für spontansprachliche Daten anhand des Forschungsund Lehrkorpus Gesprochenes Deutsch 2 FOLK Forschungs- und Lehrkorpus

Inaugural-Dissertation. Philosophie

Ontology On Demand Vollautomatische Ontologieerstellung aus deutschen Texten mithilfe moderner Textmining-Prozesse Inaugural-Dissertation zur Erlangung des Grades eines Doktors der Philosophie in der Fakultät

Ontology On Demand Vollautomatische Ontologieerstellung aus deutschen Texten mithilfe moderner Textmining-Prozesse Inaugural-Dissertation zur Erlangung des Grades eines Doktors der Philosophie in der Fakultät

Algorithmen und Formale Sprachen

Algorithmen und Formale Sprachen Algorithmen und formale Sprachen Formale Sprachen und Algorithmen Formale Sprachen und formale Algorithmen (formale (Sprachen und Algorithmen)) ((formale Sprachen) und

Algorithmen und Formale Sprachen Algorithmen und formale Sprachen Formale Sprachen und Algorithmen Formale Sprachen und formale Algorithmen (formale (Sprachen und Algorithmen)) ((formale Sprachen) und

Teil II: Phrasen und Phrasenstruktur

Teil II: Phrasen und Phrasenstruktur Übersicht: Grammatische Funktionen Kategorien Konstituenten & Strukturbäume Konstituententest Endozentrizität 1 Einfacher Satzbau Drei allgemeine Grundfragen der Syntax:

Teil II: Phrasen und Phrasenstruktur Übersicht: Grammatische Funktionen Kategorien Konstituenten & Strukturbäume Konstituententest Endozentrizität 1 Einfacher Satzbau Drei allgemeine Grundfragen der Syntax:

INFORMATIONSGEWINNUNG AUS KURZEN TEXTEN

INFORMATIONSGEWINNUNG AUS KURZEN TEXTEN T-SYSTEMS MULTIMEDIA SOLUTIONS GMBH, 14. OKTOBER 2011 1. Schlüsselworte Semantik, Informationsextraktion, Automatisierte Syntaxanalyse, Validierung, Chunking, Tagging,

INFORMATIONSGEWINNUNG AUS KURZEN TEXTEN T-SYSTEMS MULTIMEDIA SOLUTIONS GMBH, 14. OKTOBER 2011 1. Schlüsselworte Semantik, Informationsextraktion, Automatisierte Syntaxanalyse, Validierung, Chunking, Tagging,

Arbeitsblattsammlung Kommasetzung für die SEK 1

Arbeitsblattsammlung Kommasetzung für die SEK 1 Das Komma ist ein Satzzeichen welches lange Sätze inhaltlich gliedert übersichtlich einteilt und dem Leser hilft diese besser zu verstehen. Noch einmal:

Arbeitsblattsammlung Kommasetzung für die SEK 1 Das Komma ist ein Satzzeichen welches lange Sätze inhaltlich gliedert übersichtlich einteilt und dem Leser hilft diese besser zu verstehen. Noch einmal:

Illustrierende Aufgaben zum LehrplanPLUS

Ich treffe Neuer. Verben mit unterschiedlicher Valenz Jahrgangsstufen 3/4 Fach Benötigtes Material Deutsch von Schülerinnen und Schülern generierte Sätze zu ein-, zweiund dreiwertigen Verben (z. B. auf

Ich treffe Neuer. Verben mit unterschiedlicher Valenz Jahrgangsstufen 3/4 Fach Benötigtes Material Deutsch von Schülerinnen und Schülern generierte Sätze zu ein-, zweiund dreiwertigen Verben (z. B. auf

HPSG. Referat zu dem Thema Kongruenz im Englischen Von Anja Nerstheimer

HPSG Referat zu dem Thema Kongruenz im Englischen Von Anja Nerstheimer Gliederung Einleitung Kongruenz Allgemein Zwei Theorien der Kongruenz Probleme bei ableitungsbasierenden Kongruenztheorien Wie syntaktisch

HPSG Referat zu dem Thema Kongruenz im Englischen Von Anja Nerstheimer Gliederung Einleitung Kongruenz Allgemein Zwei Theorien der Kongruenz Probleme bei ableitungsbasierenden Kongruenztheorien Wie syntaktisch

5 Benutzungsoberfläche

5 Mit Ausnahme der in Kapitel 4.1 beschriebenen ÜNs wurde das Verfahren zur Transformation von Hauptansprüchen als JAVA-Anwendung implementiert. Die Anwendung, genannt ClaimTransformer, umfasst zusätzlich

5 Mit Ausnahme der in Kapitel 4.1 beschriebenen ÜNs wurde das Verfahren zur Transformation von Hauptansprüchen als JAVA-Anwendung implementiert. Die Anwendung, genannt ClaimTransformer, umfasst zusätzlich

Friedrich-Alexander-Universität Professur für Computerlinguistik. Nguyen Ai Huong

Part-of-Speech Tagging Friedrich-Alexander-Universität Professur für Computerlinguistik Nguyen Ai Huong 15.12.2011 Part-of-speech tagging Bestimmung von Wortform (part of speech) für jedes Wort in einem

Part-of-Speech Tagging Friedrich-Alexander-Universität Professur für Computerlinguistik Nguyen Ai Huong 15.12.2011 Part-of-speech tagging Bestimmung von Wortform (part of speech) für jedes Wort in einem

Erkennung von Teilsatzgrenzen

Erkennung von Teilsatzgrenzen Maryia Fedzechkina Universität zu Köln Institut für Linguistik Sprachliche Informationsverarbeitung SoSe 2007 Hauptseminar Maschinelle Sprachverarbeitung Agenda Definitionen

Erkennung von Teilsatzgrenzen Maryia Fedzechkina Universität zu Köln Institut für Linguistik Sprachliche Informationsverarbeitung SoSe 2007 Hauptseminar Maschinelle Sprachverarbeitung Agenda Definitionen

3. Das Reinforcement Lernproblem

3. Das Reinforcement Lernproblem 1. Agierender Agent in der Umgebung 2. Discounted Rewards 3. Markov Eigenschaft des Zustandssignals 4. Markov sche Entscheidung 5. Werte-Funktionen und Bellman sche Optimalität

3. Das Reinforcement Lernproblem 1. Agierender Agent in der Umgebung 2. Discounted Rewards 3. Markov Eigenschaft des Zustandssignals 4. Markov sche Entscheidung 5. Werte-Funktionen und Bellman sche Optimalität

Einführung in die Sprachwissenschaft des Deutschen. Syntax IV. PD Dr. Alexandra Zepter

Einführung in die Sprachwissenschaft des Deutschen Syntax IV PD Dr. Alexandra Zepter Überblick Syntax Fokus auf linearer Ordnung: Sprachtypen, Topologisches Feldermodell Fokus auf hierarchischer Ordnung:

Einführung in die Sprachwissenschaft des Deutschen Syntax IV PD Dr. Alexandra Zepter Überblick Syntax Fokus auf linearer Ordnung: Sprachtypen, Topologisches Feldermodell Fokus auf hierarchischer Ordnung:

Ausarbeitung zum Modulabschluss. Graphentheorie. spannende Bäume, bewertete Graphen, optimale Bäume, Verbindungsprobleme

Universität Hamburg Fachbereich Mathematik Seminar: Proseminar Graphentheorie Dozentin: Haibo Ruan Sommersemester 2011 Ausarbeitung zum Modulabschluss Graphentheorie spannende Bäume, bewertete Graphen,

Universität Hamburg Fachbereich Mathematik Seminar: Proseminar Graphentheorie Dozentin: Haibo Ruan Sommersemester 2011 Ausarbeitung zum Modulabschluss Graphentheorie spannende Bäume, bewertete Graphen,

Programmieren in natürlicher Sprache: Alice-Kontrollstrukturen

Programmieren in natürlicher Sprache: Alice-Kontrollstrukturen Bachelorarbeit betreut von Mathias Landhäußer Ronny Hug 20. August 2014 IPD TICHY KIT Universität des Landes Baden-Württemberg und nationales

Programmieren in natürlicher Sprache: Alice-Kontrollstrukturen Bachelorarbeit betreut von Mathias Landhäußer Ronny Hug 20. August 2014 IPD TICHY KIT Universität des Landes Baden-Württemberg und nationales

Syntax von Programmiersprachen

"Grammatik, die sogar Könige zu kontrollieren weiß... aus Molière, Les Femmes Savantes (1672), 2. Akt Syntax von Programmiersprachen Prof. Dr. Christian Böhm in Zusammenarbeit mit Gefei Zhang WS 07/08

"Grammatik, die sogar Könige zu kontrollieren weiß... aus Molière, Les Femmes Savantes (1672), 2. Akt Syntax von Programmiersprachen Prof. Dr. Christian Böhm in Zusammenarbeit mit Gefei Zhang WS 07/08

Seminar Ib Wort, Name, Begriff, Terminus Sommersemester Morphologie. Walther v.hahn. v.hahn Universität Hamburg

Seminar Ib Wort, Name, Begriff, Terminus Sommersemester 2006 Morphologie Walther v.hahn v.hahn Universität Hamburg 2005 1 Morphologie: Definition Definitionen: Morphologie ist die Lehre von den Klassen

Seminar Ib Wort, Name, Begriff, Terminus Sommersemester 2006 Morphologie Walther v.hahn v.hahn Universität Hamburg 2005 1 Morphologie: Definition Definitionen: Morphologie ist die Lehre von den Klassen

Freihand-Editieren von mathematischen Formeln

Freihand-Editieren von mathematischen Formeln Seminar Mustererkennung mit syntaktischen und graphbasierten Methoden Maria Heym, 17.01.2006 Gliederung 1.Erschwernisse bei mathematischen Formeln 2. Frühe

Freihand-Editieren von mathematischen Formeln Seminar Mustererkennung mit syntaktischen und graphbasierten Methoden Maria Heym, 17.01.2006 Gliederung 1.Erschwernisse bei mathematischen Formeln 2. Frühe

KAPITEL I EINLEITUNG

KAPITEL I EINLEITUNG A. Der Hintergrund Die Wortklasse oder part of speech hat verschiedene Merkmale. Nach dem traditionellen System werden die deutschen Wortklassen in zehn Klassen unterteilt (Gross,

KAPITEL I EINLEITUNG A. Der Hintergrund Die Wortklasse oder part of speech hat verschiedene Merkmale. Nach dem traditionellen System werden die deutschen Wortklassen in zehn Klassen unterteilt (Gross,

Einführung in die Sprachwissenschaft -Tutorium-

Ruprecht-Karls-Universität Heidelberg Seminar für Computerlinguistik Wintersemester 2010/2011 Einführung in die Sprachwissenschaft -Tutorium- Dienstag, 16.00 18.00 Uhr Seminarraum 10 Aufgaben Kapitel 1

Ruprecht-Karls-Universität Heidelberg Seminar für Computerlinguistik Wintersemester 2010/2011 Einführung in die Sprachwissenschaft -Tutorium- Dienstag, 16.00 18.00 Uhr Seminarraum 10 Aufgaben Kapitel 1

Zur Anwendung heuristischer Hilfsmittel beim Lösen von Sachaufgaben im Mathematikunterricht der Grundschule

Naturwissenschaft Stefanie Kahl Zur Anwendung heuristischer Hilfsmittel beim Lösen von Sachaufgaben im Mathematikunterricht der Grundschule Examensarbeit Zur Anwendung heuristischer Hilfsmittel beim Lösen

Naturwissenschaft Stefanie Kahl Zur Anwendung heuristischer Hilfsmittel beim Lösen von Sachaufgaben im Mathematikunterricht der Grundschule Examensarbeit Zur Anwendung heuristischer Hilfsmittel beim Lösen

Universität Potsdam Institut für Informatik Lehrstuhl Maschinelles Lernen. NLP-Pipeline. Tobias Scheffer Thomas Vanck

Universität Potsdam Institut für Informatik Lehrstuhl Maschinelles Lernen NLP-Pipeline Tobias Scheffer Thomas Vanck NLP-Pipeline Folge von Verarbeitungsschritten für Informationsextraktion, Übersetzung,

Universität Potsdam Institut für Informatik Lehrstuhl Maschinelles Lernen NLP-Pipeline Tobias Scheffer Thomas Vanck NLP-Pipeline Folge von Verarbeitungsschritten für Informationsextraktion, Übersetzung,

Automatische Erkennung von Figuren in deutschsprachigen Romanen

Automatische Erkennung von Figuren in deutschsprachigen Romanen Jannidis, Fotis fotis.jannidis@uni-wuerzburg.de, Universität Würzburg Krug, Markus markus.krug@uni-wuerzburg.de, Universität Würzburg Reger,

Automatische Erkennung von Figuren in deutschsprachigen Romanen Jannidis, Fotis fotis.jannidis@uni-wuerzburg.de, Universität Würzburg Krug, Markus markus.krug@uni-wuerzburg.de, Universität Würzburg Reger,

Einführung Syntaktische Funktionen

Syntax I Einführung Syntaktische Funktionen Syntax I 1 Syntax allgemein Syntax befasst sich mit den Regeln, mit denen man Wörter zu grammatischen Sätzen kombinieren kann. Es gibt unterschiedliche Modelle

Syntax I Einführung Syntaktische Funktionen Syntax I 1 Syntax allgemein Syntax befasst sich mit den Regeln, mit denen man Wörter zu grammatischen Sätzen kombinieren kann. Es gibt unterschiedliche Modelle

Terminus Sprache, Phonologie und Grammatik

Terminus Sprache, Phonologie und Grammatik Terminus Sprache Beinhaltet 4 verschiedene Bedeutungen Langage: menschliche Fähigkeit Langue: eine bestimmte Sprache, Untersuchungsgebiet der Linguistik Parole:

Terminus Sprache, Phonologie und Grammatik Terminus Sprache Beinhaltet 4 verschiedene Bedeutungen Langage: menschliche Fähigkeit Langue: eine bestimmte Sprache, Untersuchungsgebiet der Linguistik Parole:

Terminologie-Extraktion: Beispiel

Terminologie-Extraktion: Beispiel The major risks of long-term cardiotoxicity relate to treatment prior to the BMT, in particular, anthracyclines, ablative-dose Cytoxan (ie, dose > 150 mg/ kg), chest [radiation

Terminologie-Extraktion: Beispiel The major risks of long-term cardiotoxicity relate to treatment prior to the BMT, in particular, anthracyclines, ablative-dose Cytoxan (ie, dose > 150 mg/ kg), chest [radiation

Warum Named Entities für die Chunk-Analyse wichtig sind

Warum Named Entities für die Chunk-Analyse wichtig sind Ilona Steiner Zusammenfassung In diesem Papier wird untersucht, inwiefern in Systemen zur syntaktischen Annotation von deutschen Korpora die Erkennung

Warum Named Entities für die Chunk-Analyse wichtig sind Ilona Steiner Zusammenfassung In diesem Papier wird untersucht, inwiefern in Systemen zur syntaktischen Annotation von deutschen Korpora die Erkennung

Satzlehre Satzglieder funktional bestimmen Lösung

Gymbasis Deutsch: Grammatik Satzlehre Satzglieder funktional bestimmen Lösung 1 Satzlehre Satzglieder funktional bestimmen Lösung 1. Schritt: Unterstreiche in den folgenden Sätzen alle Satzglieder. Das

Gymbasis Deutsch: Grammatik Satzlehre Satzglieder funktional bestimmen Lösung 1 Satzlehre Satzglieder funktional bestimmen Lösung 1. Schritt: Unterstreiche in den folgenden Sätzen alle Satzglieder. Das

Programmierkurs Python II

Programmierkurs Python II Michaela Regneri & tefan Thater FR 4.7 Allgemeine Linguistik (Computerlinguistik) Universität des aarlandes ommersemester 2010 (Charniak, 1997) the dog biscuits N V N V the dog

Programmierkurs Python II Michaela Regneri & tefan Thater FR 4.7 Allgemeine Linguistik (Computerlinguistik) Universität des aarlandes ommersemester 2010 (Charniak, 1997) the dog biscuits N V N V the dog

Grammatikanalyse. Prof. Dr. John Peterson. Sprechstunde: Montags, 14:30-15:30h Raum LS10/Raum 425. Sommersemester 2015 Donnerstags, 14:15h-15:45h

Grammatikanalyse Sommersemester 2015 Donnerstags, 14:15h-15:45h Prof. Dr. John Peterson Sprechstunde: Montags, 14:30-15:30h Raum LS10/Raum 425 1 Termin Thema 16.4. Einführung Zerlegung des Satzes in seine

Grammatikanalyse Sommersemester 2015 Donnerstags, 14:15h-15:45h Prof. Dr. John Peterson Sprechstunde: Montags, 14:30-15:30h Raum LS10/Raum 425 1 Termin Thema 16.4. Einführung Zerlegung des Satzes in seine

Algorithmen mit konstantem Platzbedarf: Die Klasse REG

Algorithmen mit konstantem Platzbedarf: Die Klasse REG Sommerakademie Rot an der Rot AG 1 Wieviel Platz brauchen Algorithmen wirklich? Daniel Alm Institut für Numerische Simulation Universität Bonn August

Algorithmen mit konstantem Platzbedarf: Die Klasse REG Sommerakademie Rot an der Rot AG 1 Wieviel Platz brauchen Algorithmen wirklich? Daniel Alm Institut für Numerische Simulation Universität Bonn August

Erkennung fremdsprachiger Ausdrücke im Text

Erkennung fremdsprachiger Ausdrücke im Text Jekaterina Siilivask Betreuer: Dr. Helmut Schmid Centrum für Informations- und Sprachbearbeiting Ludwig- Maximilians- Universität München 19.05.2014 Jekaterina

Erkennung fremdsprachiger Ausdrücke im Text Jekaterina Siilivask Betreuer: Dr. Helmut Schmid Centrum für Informations- und Sprachbearbeiting Ludwig- Maximilians- Universität München 19.05.2014 Jekaterina

Wiederholung: Korpuslinguistik. Einführung in die Korpuslinguistik. Vorverarbeitung: Themen. Vorverarbeitung. Vorverarbeitung.

Wiederholung: Korpuslinguistik Einführung in die Korpuslinguistik Anke Lüdeling anke.luedeling@rz.hu-berlin.de Sommersemester 2007 beschäftigt sich damit, welche linguistischen Fragen anhand (großer) Textmengen

Wiederholung: Korpuslinguistik Einführung in die Korpuslinguistik Anke Lüdeling anke.luedeling@rz.hu-berlin.de Sommersemester 2007 beschäftigt sich damit, welche linguistischen Fragen anhand (großer) Textmengen

Übung zur Vorlesung Einführung in die Computerlinguistik und Sprachtechnologie

Übung zur Vorlesung Einführung in die Computerlinguistik und Sprachtechnologie Wintersemester 2009/10, Prof. Dr. Udo Hahn, Erik Fäßler Übungsblatt 6 vom 10.12.2009 Abgabe bis 15.12.2009, 23:59 Uhr; per

Übung zur Vorlesung Einführung in die Computerlinguistik und Sprachtechnologie Wintersemester 2009/10, Prof. Dr. Udo Hahn, Erik Fäßler Übungsblatt 6 vom 10.12.2009 Abgabe bis 15.12.2009, 23:59 Uhr; per

Grammatik des Standarddeutschen III. Michael Schecker

Grammatik des Standarddeutschen III Michael Schecker Einführung und Grundlagen Nominalgruppen Nomina Artikel Attribute Pronomina Kasus (Subjekte und Objekte, Diathese) Verbalgruppen Valenz und Argumente

Grammatik des Standarddeutschen III Michael Schecker Einführung und Grundlagen Nominalgruppen Nomina Artikel Attribute Pronomina Kasus (Subjekte und Objekte, Diathese) Verbalgruppen Valenz und Argumente

Seminar Textmining SS 2015 Grundlagen des Maschinellen Lernens

Seminar Textmining SS 2015 Grundlagen des Maschinellen Lernens Martin Hacker Richard Schaller Künstliche Intelligenz Department Informatik FAU Erlangen-Nürnberg 17.04.2015 Entscheidungsprobleme beim Textmining

Seminar Textmining SS 2015 Grundlagen des Maschinellen Lernens Martin Hacker Richard Schaller Künstliche Intelligenz Department Informatik FAU Erlangen-Nürnberg 17.04.2015 Entscheidungsprobleme beim Textmining

Tagging von Online-Blogs

Tagging von Online-Blogs Gertrud Faaß (vertreten durch Josef Ruppenhofer) STTS tagset and tagging: special corpora 24. September 2012 Faaß MODEBLOGS 1 Korpuslinguistische studentische Projekte am IwiSt

Tagging von Online-Blogs Gertrud Faaß (vertreten durch Josef Ruppenhofer) STTS tagset and tagging: special corpora 24. September 2012 Faaß MODEBLOGS 1 Korpuslinguistische studentische Projekte am IwiSt

Testdokument (Universität Paderborn, Softwaretechnikpraktikum SS2006)

Testdokument (Universität Paderborn, Softwaretechnikpraktikum SS2006) Alles, was in dieser Schriftart gesetzt ist, dient nur zur Erläuterung und sollte im fertigen Dokument nicht mehr enthalten sein! Projekt:

Testdokument (Universität Paderborn, Softwaretechnikpraktikum SS2006) Alles, was in dieser Schriftart gesetzt ist, dient nur zur Erläuterung und sollte im fertigen Dokument nicht mehr enthalten sein! Projekt:

Routing Algorithmen. Begriffe, Definitionen

Begriffe, Definitionen Routing (aus der Informatik) Wegewahl oder Verkehrslenkung bezeichnet in der Telekommunikation das Festlegen von Wegen für Nachrichtenströme bei der Nachrichtenübermittlung über

Begriffe, Definitionen Routing (aus der Informatik) Wegewahl oder Verkehrslenkung bezeichnet in der Telekommunikation das Festlegen von Wegen für Nachrichtenströme bei der Nachrichtenübermittlung über

Universität Karlsruhe (TH)

Universität Karlsruhe (TH) Lehrstuhl für Programmierparadigmen prachtechnologie und Compiler W 2008/2009 http://pp.info.uni-karlsruhe.de/ Dozent: Prof. Dr.-Ing. G. nelting snelting@ipd.info.uni-karlsruhe.de

Universität Karlsruhe (TH) Lehrstuhl für Programmierparadigmen prachtechnologie und Compiler W 2008/2009 http://pp.info.uni-karlsruhe.de/ Dozent: Prof. Dr.-Ing. G. nelting snelting@ipd.info.uni-karlsruhe.de

Einführung in die Computerlinguistik Statistische Grundlagen

Statistik 1 Sommer 2015 Einführung in die Computerlinguistik Statistische Grundlagen Laura Heinrich-Heine-Universität Düsseldorf Sommersemester 2015 Statistik 2 Sommer 2015 Überblick 1. Diskrete Wahrscheinlichkeitsräume

Statistik 1 Sommer 2015 Einführung in die Computerlinguistik Statistische Grundlagen Laura Heinrich-Heine-Universität Düsseldorf Sommersemester 2015 Statistik 2 Sommer 2015 Überblick 1. Diskrete Wahrscheinlichkeitsräume

Kontextsensitive Sprachen

Kontextsensitive Sprachen Standardbeispiel: {anbncn} S a b c S a A b B c c B A B b c B b b A A b a A a a Im Bereich der natürlichen Sprachen gibt es zahlreiche kontextsensitive Phänomene in der Semantik

Kontextsensitive Sprachen Standardbeispiel: {anbncn} S a b c S a A b B c c B A B b c B b b A A b a A a a Im Bereich der natürlichen Sprachen gibt es zahlreiche kontextsensitive Phänomene in der Semantik

Grundlegende Eigenschaften von Punktschätzern

Grundlegende Eigenschaften von Punktschätzern Worum geht es in diesem Modul? Schätzer als Zufallsvariablen Vorbereitung einer Simulation Verteilung von P-Dach Empirische Lage- und Streuungsparameter zur

Grundlegende Eigenschaften von Punktschätzern Worum geht es in diesem Modul? Schätzer als Zufallsvariablen Vorbereitung einer Simulation Verteilung von P-Dach Empirische Lage- und Streuungsparameter zur

optivo broadmail Professionelles E-Mail-Marketing Klick-Profilierung: Einfach und effektiv Zielgruppen erstellen

optivo broadmail Professionelles E-Mail-Marketing Klick-Profilierung: Einfach und effektiv Zielgruppen erstellen Inhalt 1. 2.. 4. 5. Mit Klick-Profilierung Tracking-Links taggen und verwalten.................................................................................

optivo broadmail Professionelles E-Mail-Marketing Klick-Profilierung: Einfach und effektiv Zielgruppen erstellen Inhalt 1. 2.. 4. 5. Mit Klick-Profilierung Tracking-Links taggen und verwalten.................................................................................

Terminologie vs. kontrolliertes Vokabular Unterschiede, Gemeinsamkeiten, sinnvolle Kombinationen. Ursula Reuther

Terminologie vs. kontrolliertes Vokabular Unterschiede, Gemeinsamkeiten, sinnvolle Kombinationen tekom Frühjahrstagung, Karlsruhe, 27. April 2012 Übersicht Terminologiearbeit Entstehung von Terminologie

Terminologie vs. kontrolliertes Vokabular Unterschiede, Gemeinsamkeiten, sinnvolle Kombinationen tekom Frühjahrstagung, Karlsruhe, 27. April 2012 Übersicht Terminologiearbeit Entstehung von Terminologie

Part-Of-Speech-Tagging mit Viterbi Algorithmus

Part-Of-Speech-Tagging mit Viterbi Algorithmus HS Endliche Automaten Inna Nickel, Julia Konstantinova 19.07.2010 1 / 21 Gliederung 1 Motivation 2 Theoretische Grundlagen Hidden Markov Model Viterbi Algorithmus

Part-Of-Speech-Tagging mit Viterbi Algorithmus HS Endliche Automaten Inna Nickel, Julia Konstantinova 19.07.2010 1 / 21 Gliederung 1 Motivation 2 Theoretische Grundlagen Hidden Markov Model Viterbi Algorithmus

"What's in the news? - or: why Angela Merkel is not significant

"What's in the news? - or: why Angela Merkel is not significant Andrej Rosenheinrich, Dr. Bernd Eickmann Forschung und Entwicklung, Unister GmbH, Leipzig UNISTER Seite 1 Unister Holding UNISTER Seite 2

"What's in the news? - or: why Angela Merkel is not significant Andrej Rosenheinrich, Dr. Bernd Eickmann Forschung und Entwicklung, Unister GmbH, Leipzig UNISTER Seite 1 Unister Holding UNISTER Seite 2

9. Heuristische Suche

9. Heuristische Suche Prof. Dr. Rudolf Kruse University of Magdeburg Faculty of Computer Science Magdeburg, Germany rudolf.kruse@cs.uni-magdeburg.de S Heuristische Suche Idee: Wir nutzen eine (heuristische)

9. Heuristische Suche Prof. Dr. Rudolf Kruse University of Magdeburg Faculty of Computer Science Magdeburg, Germany rudolf.kruse@cs.uni-magdeburg.de S Heuristische Suche Idee: Wir nutzen eine (heuristische)

KAPITEL I EINLEITUNG

KAPITEL I EINLEITUNG A. Hintergrund Sprache spielt eine wichtige Rolle im menschlichen Leben. Die Sprache wird von den Menschen benutzt um Gedanken, Gefühle und menschlichen Handels auszudrücken. Mit Sprache

KAPITEL I EINLEITUNG A. Hintergrund Sprache spielt eine wichtige Rolle im menschlichen Leben. Die Sprache wird von den Menschen benutzt um Gedanken, Gefühle und menschlichen Handels auszudrücken. Mit Sprache

Kaplan-Meier-Schätzer

Kaplan-Meier-Schätzer Ausgangssituation Zwei naive Ansätze zur Schätzung der Survivalfunktion Unverzerrte Schätzung der Survivalfunktion Der Kaplan-Meier-Schätzer Standardfehler und Konfidenzintervall

Kaplan-Meier-Schätzer Ausgangssituation Zwei naive Ansätze zur Schätzung der Survivalfunktion Unverzerrte Schätzung der Survivalfunktion Der Kaplan-Meier-Schätzer Standardfehler und Konfidenzintervall

Erläuterung des Begriffs Plagiat

Erläuterung des Begriffs Plagiat 1 Definition Plagiat Unter einem Plagiat versteht man allgemein die Wiedergabe eines Textteils ohne Herkunftsangabe. Besonders zu beachten ist, dass es unerheblich ist,

Erläuterung des Begriffs Plagiat 1 Definition Plagiat Unter einem Plagiat versteht man allgemein die Wiedergabe eines Textteils ohne Herkunftsangabe. Besonders zu beachten ist, dass es unerheblich ist,

Excel 2013. Grundlagen. Sabine Spieß, Peter Wies. 1. Ausgabe, September 2013. Trainermedienpaket EX2013_TMP

Excel 2013 Sabine Spieß, Peter Wies Grundlagen 1. Ausgabe, September 2013 Trainermedienpaket EX2013_TMP 12 Excel 2013 - Grundlagen 12 Spezielle Gestaltungsmöglichkeiten nutzen Trainerhinweise Unterrichtsdauer

Excel 2013 Sabine Spieß, Peter Wies Grundlagen 1. Ausgabe, September 2013 Trainermedienpaket EX2013_TMP 12 Excel 2013 - Grundlagen 12 Spezielle Gestaltungsmöglichkeiten nutzen Trainerhinweise Unterrichtsdauer

Linguistik für Kognitionswissenschaften

Linguistik für Kognitionswissenschaften Computerlinguistik: Maschinelle Übersetzung Computerlinguistik Fehlübersetzung von engl. computational linguistics - computationelle Linguistik beinhaltet im weiteren

Linguistik für Kognitionswissenschaften Computerlinguistik: Maschinelle Übersetzung Computerlinguistik Fehlübersetzung von engl. computational linguistics - computationelle Linguistik beinhaltet im weiteren

Hannah Wester Juan Jose Gonzalez

Neuronale Netze Supervised Learning Proseminar Kognitive Robotik (SS12) Hannah Wester Juan Jose Gonzalez Kurze Einführung Warum braucht man Neuronale Netze und insbesondere Supervised Learning? Das Perzeptron

Neuronale Netze Supervised Learning Proseminar Kognitive Robotik (SS12) Hannah Wester Juan Jose Gonzalez Kurze Einführung Warum braucht man Neuronale Netze und insbesondere Supervised Learning? Das Perzeptron

Projekt Maschinelles Lernen WS 06/07

Projekt Maschinelles Lernen WS 06/07 1. Auswahl der Daten 2. Evaluierung 3. Noise und Pruning 4. Regel-Lernen 5. ROC-Kurven 6. Pre-Processing 7. Entdecken von Assoziationsregeln 8. Ensemble-Lernen 9. Wettbewerb

Projekt Maschinelles Lernen WS 06/07 1. Auswahl der Daten 2. Evaluierung 3. Noise und Pruning 4. Regel-Lernen 5. ROC-Kurven 6. Pre-Processing 7. Entdecken von Assoziationsregeln 8. Ensemble-Lernen 9. Wettbewerb

Korpora. Referenten Duyen Tao-Pham Nedyalko Georgiev

Korpora Referenten Duyen Tao-Pham Nedyalko Georgiev Hauptseminar: Angewandte Linguistische Datenverarbeitung (WS 11/12) Dozent: Prof. Dr. Jürgen Rolshoven Sprachliche Informationsverarbeitung Universität

Korpora Referenten Duyen Tao-Pham Nedyalko Georgiev Hauptseminar: Angewandte Linguistische Datenverarbeitung (WS 11/12) Dozent: Prof. Dr. Jürgen Rolshoven Sprachliche Informationsverarbeitung Universität

Unterrichtsmaterialien in digitaler und in gedruckter Form. Auszug aus: Kein leichter Fall - das deutsche Kasussystem

Unterrichtsmaterialien in digitaler und in gedruckter Form Auszug aus: Kein leichter Fall - das deutsche Kasussystem Das komplette Material finden Sie hier: School-Scout.de 2 von 28 Kasus Grammatik und

Unterrichtsmaterialien in digitaler und in gedruckter Form Auszug aus: Kein leichter Fall - das deutsche Kasussystem Das komplette Material finden Sie hier: School-Scout.de 2 von 28 Kasus Grammatik und

Erkennung menschlicher Aktionen durch Inferenz stochastischer regulärer Grammatiken

BTU Cottbus Seminar "Mustererkennung mit syntaktischen und graphbasierten Methoden" Wintersemester 2006/2007 Vortrag zum Thema: Erkennung menschlicher Aktionen durch Inferenz stochastischer regulärer Grammatiken

BTU Cottbus Seminar "Mustererkennung mit syntaktischen und graphbasierten Methoden" Wintersemester 2006/2007 Vortrag zum Thema: Erkennung menschlicher Aktionen durch Inferenz stochastischer regulärer Grammatiken

Die Wortbildung des Deutschen. Wortbildungsmittel

Die Wortbildung des Deutschen Wortbildungsmittel Voraussetzungen und Ziele der Wortbildungsanalyse Bildung von Wörtern folgt best. Wortbildungstypen Bildung nach Vorbild eines bereits bekannten Wortes

Die Wortbildung des Deutschen Wortbildungsmittel Voraussetzungen und Ziele der Wortbildungsanalyse Bildung von Wörtern folgt best. Wortbildungstypen Bildung nach Vorbild eines bereits bekannten Wortes

Einführung in die Computerlinguistik Morphologie (1): morphembasierte Morphologie mit Transduktoren

Einführung in die Computerlinguistik Morphologie (1): morphembasierte Morphologie mit Transduktoren Dozentin: Wiebke Petersen 14.6.2010 Wiebke Petersen Einführung CL SoSe 2010 1 Morphologische Grundbegrie

Einführung in die Computerlinguistik Morphologie (1): morphembasierte Morphologie mit Transduktoren Dozentin: Wiebke Petersen 14.6.2010 Wiebke Petersen Einführung CL SoSe 2010 1 Morphologische Grundbegrie

Formale Methoden 1. Gerhard Jäger 12. Dezember Uni Bielefeld, WS 2007/2008 1/22

1/22 Formale Methoden 1 Gerhard Jäger Gerhard.Jaeger@uni-bielefeld.de Uni Bielefeld, WS 2007/2008 12. Dezember 2007 2/22 Bäume Baumdiagramme Ein Baumdiagramm eines Satzes stellt drei Arten von Information

1/22 Formale Methoden 1 Gerhard Jäger Gerhard.Jaeger@uni-bielefeld.de Uni Bielefeld, WS 2007/2008 12. Dezember 2007 2/22 Bäume Baumdiagramme Ein Baumdiagramm eines Satzes stellt drei Arten von Information

Weka: Software-Suite mit Maschineller Lernsoftware

: Software-Suite mit Maschineller Lernsoftware Computational Linguistics Universität des Saarlandes Sommersemester 2011 21.04.2011 Erste Schritte Waikato Environment for Knowledge Analysis entwickelt von

: Software-Suite mit Maschineller Lernsoftware Computational Linguistics Universität des Saarlandes Sommersemester 2011 21.04.2011 Erste Schritte Waikato Environment for Knowledge Analysis entwickelt von

Regelbasierte Zufallsgenerierung von Gebäudemodellen aus Bebauungsplänen mit der Software CityEngine

Motivation Regelbasierte Zufallsgenerierung von Gebäudemodellen aus Bebauungsplänen mit der Software CityEngine Abbildung 1: 2D Gebäudeumriss Ein zweidimensionaler Gebäudeumriss, wie die Abbildung Abbildung

Motivation Regelbasierte Zufallsgenerierung von Gebäudemodellen aus Bebauungsplänen mit der Software CityEngine Abbildung 1: 2D Gebäudeumriss Ein zweidimensionaler Gebäudeumriss, wie die Abbildung Abbildung

«Titel der Arbeit» SEMINARARBEIT. an der. Universität Regensburg. Eingereicht bei der Honorarprofessur für Wirtschaftsinformatik,

«Titel der Arbeit» SEMINARARBEIT an der Universität Regensburg Eingereicht bei der Honorarprofessur für Wirtschaftsinformatik, -Prof. Dr. Hans-Gert Penzel- von: Name, Vorname Matrikel-Nr.: 123 456 Adresse:

«Titel der Arbeit» SEMINARARBEIT an der Universität Regensburg Eingereicht bei der Honorarprofessur für Wirtschaftsinformatik, -Prof. Dr. Hans-Gert Penzel- von: Name, Vorname Matrikel-Nr.: 123 456 Adresse:

Syntaktische Annotationen. Korpuslinguistik Dr. Heike Zinsmeister

Syntaktische Annotationen Korpuslinguistik Dr. Heike Zinsmeister 18.11.2011 Syntax Gestern war mir, wie vielen europäischen Abgeordneten, die Teilnahme unmöglich, da der Flug von Air France, mit dem wir

Syntaktische Annotationen Korpuslinguistik Dr. Heike Zinsmeister 18.11.2011 Syntax Gestern war mir, wie vielen europäischen Abgeordneten, die Teilnahme unmöglich, da der Flug von Air France, mit dem wir

Datenstrukturen & Algorithmen

Datenstrukturen & Algorithmen Matthias Zwicker Universität Bern Frühling 2010 Übersicht Dynamische Programmierung Einführung Ablaufkoordination von Montagebändern Längste gemeinsame Teilsequenz Optimale

Datenstrukturen & Algorithmen Matthias Zwicker Universität Bern Frühling 2010 Übersicht Dynamische Programmierung Einführung Ablaufkoordination von Montagebändern Längste gemeinsame Teilsequenz Optimale

SQL. SQL SELECT Anweisung SQL-SELECT SQL-SELECT

SQL SQL SELECT Anweisung Mit der SQL SELECT-Anweisung werden Datenwerte aus einer oder mehreren Tabellen einer Datenbank ausgewählt. Das Ergebnis der Auswahl ist erneut eine Tabelle, die sich dynamisch

SQL SQL SELECT Anweisung Mit der SQL SELECT-Anweisung werden Datenwerte aus einer oder mehreren Tabellen einer Datenbank ausgewählt. Das Ergebnis der Auswahl ist erneut eine Tabelle, die sich dynamisch

Syntax II. Gereon Müller Institut für Linguistik 4. November Typeset by FoilTEX

Syntax II Gereon Müller Institut für Linguistik heck@uni-leipzig.de gereon.mueller@uni-leipzig.de 4. November 2014 Typeset by FoilTEX [A] Kasus, 4. Teil [1] Inhärente vs. strukturelle Kasus: Fanselow (1999)

Syntax II Gereon Müller Institut für Linguistik heck@uni-leipzig.de gereon.mueller@uni-leipzig.de 4. November 2014 Typeset by FoilTEX [A] Kasus, 4. Teil [1] Inhärente vs. strukturelle Kasus: Fanselow (1999)

Kapitel ML: I. I. Einführung. Beispiele für Lernaufgaben Spezifikation von Lernproblemen

Kapitel ML: I I. Einführung Beispiele für Lernaufgaben Spezifikation von Lernproblemen ML: I-8 Introduction c STEIN/LETTMANN 2005-2010 Beispiele für Lernaufgaben Autoeinkaufsberater Welche Kriterien liegen

Kapitel ML: I I. Einführung Beispiele für Lernaufgaben Spezifikation von Lernproblemen ML: I-8 Introduction c STEIN/LETTMANN 2005-2010 Beispiele für Lernaufgaben Autoeinkaufsberater Welche Kriterien liegen

Bericht über die Besichtigung des Flughafens

netzwerk sims Sprachförderung in mehrsprachigen Schulen 1 von 5 Bericht über die Besichtigung des Flughafens Zum vorliegenden Unterrichtsmaterial Das in diesem Beitrag vorgestellte Unterrichtsmaterial

netzwerk sims Sprachförderung in mehrsprachigen Schulen 1 von 5 Bericht über die Besichtigung des Flughafens Zum vorliegenden Unterrichtsmaterial Das in diesem Beitrag vorgestellte Unterrichtsmaterial

Alphabet, formale Sprache

n Alphabet Alphabet, formale Sprache l nichtleere endliche Menge von Zeichen ( Buchstaben, Symbole) n Wort über einem Alphabet l endliche Folge von Buchstaben, die auch leer sein kann ( ε leere Wort) l

n Alphabet Alphabet, formale Sprache l nichtleere endliche Menge von Zeichen ( Buchstaben, Symbole) n Wort über einem Alphabet l endliche Folge von Buchstaben, die auch leer sein kann ( ε leere Wort) l

Kapitel 2. Methoden zur Beschreibung von Syntax

1 Kapitel 2 Methoden zur Beschreibung von Syntax Grammatik, die sogar Könige zu kontrollieren weiß... aus Molière, Les Femmes Savantes (1672), 2. Akt 2 Ziele Zwei Standards zur Definition der Syntax von

1 Kapitel 2 Methoden zur Beschreibung von Syntax Grammatik, die sogar Könige zu kontrollieren weiß... aus Molière, Les Femmes Savantes (1672), 2. Akt 2 Ziele Zwei Standards zur Definition der Syntax von

Künstliche Intelligenz Sprachverarbeitung mit Prolog

Künstliche Intelligenz Sprachverarbeitung mit Prolog Stephan Schwiebert WS 2009/2010 Sprachliche Informationsverarbeitung Institut für Linguistik Universität zu Köln Parsing mit Prolog Grammatik Wortartenklassifikation,

Künstliche Intelligenz Sprachverarbeitung mit Prolog Stephan Schwiebert WS 2009/2010 Sprachliche Informationsverarbeitung Institut für Linguistik Universität zu Köln Parsing mit Prolog Grammatik Wortartenklassifikation,

Einführung Computerlinguistik. Konstituentensyntax II

Einführung Computerlinguistik Konstituentensyntax II Hinrich Schütze & Robert Zangenfeind Centrum für Informations- und Sprachverarbeitung, LMU München 2013-11-18 Schütze & Zangenfeind: Konstituentensyntax

Einführung Computerlinguistik Konstituentensyntax II Hinrich Schütze & Robert Zangenfeind Centrum für Informations- und Sprachverarbeitung, LMU München 2013-11-18 Schütze & Zangenfeind: Konstituentensyntax

Auswertung des IAT anla sslich der Ausstellung Check Your Stereotypes

Hanna Schiff, Honorata Kaczykowski-Patermann, Renate Schubert Auswertung des IAT anla sslich der Ausstellung Check Your Stereotypes Was ist der IAT? Stereotype sind Wegbereiter für Vorurteile und Diskriminierungen.

Hanna Schiff, Honorata Kaczykowski-Patermann, Renate Schubert Auswertung des IAT anla sslich der Ausstellung Check Your Stereotypes Was ist der IAT? Stereotype sind Wegbereiter für Vorurteile und Diskriminierungen.

Maschinelles Lernen: Symbolische Ansätze

Maschinelles Lernen: Symbolische Ansätze Wintersemester 2008/2009 Musterlösung für das 5. Übungsblatt Aufgabe 1: Covering-Algorithmus und Coverage-Space Visualisieren Sie den Ablauf des Covering-Algorithmus

Maschinelles Lernen: Symbolische Ansätze Wintersemester 2008/2009 Musterlösung für das 5. Übungsblatt Aufgabe 1: Covering-Algorithmus und Coverage-Space Visualisieren Sie den Ablauf des Covering-Algorithmus

Objektorientierte Modellierung (1)

Objektorientierte Modellierung (1) Die objektorientierte Modellierung verwendet: Klassen und deren Objekte Beziehungen zwischen Objekten bzw. Klassen Klassen und Objekte Definition Klasse Eine Klasse ist

Objektorientierte Modellierung (1) Die objektorientierte Modellierung verwendet: Klassen und deren Objekte Beziehungen zwischen Objekten bzw. Klassen Klassen und Objekte Definition Klasse Eine Klasse ist

Neben der Addition tritt nun die Multiplikation als weitere Struktureigenschaft

Kapitel 3 Rationale Zahlen 31 Die rationalen Zahlen (Körper, Abzählbarkeit) Was ist mit der Gleichung z q = w in Z? Für gegebene z, w Z ist diese Gleichung in der Menge der ganzen Zahlen im Allgemeinen

Kapitel 3 Rationale Zahlen 31 Die rationalen Zahlen (Körper, Abzählbarkeit) Was ist mit der Gleichung z q = w in Z? Für gegebene z, w Z ist diese Gleichung in der Menge der ganzen Zahlen im Allgemeinen