Head-driven Phrase Structure Grammar

|

|

|

- Jutta Kopp

- vor 6 Jahren

- Abrufe

Transkript

1 Institut für Informatik Sommersemester 2000 der Universität Zürich Computerlinguistik Head-driven Phrase Structure Grammar Eine Einführung in Seminararbeit im Rahmen des Seminars bei Prof. Dr. M. Hess, lic.phil. G. Schneider und lic.phil. S. Clematide (Erster Teil) Juliette Huber Davina Rodgers Krummenlandstrasse 21 Kapfstrasse Schinznach-Dorf 8032 Zürich Tel.: 056/ Tel.: 01/ durian@freesurf.ch DavinaRodgers@access.unizh.ch Mai 2000

2 Inhaltsverzeichnis 1. EINLEITUNG VORLÄUFERTHEORIEN CATEGORIAL GRAMMAR GENERALIZED PHRASE STRUCTURE GRAMMAR (GPSG) ARC PAIR GRAMMAR LEXICAL-FUNCTIONAL GRAMMAR (LFG) 7 2. MERKMALSTRUKTUREN UND SYNTAKTISCHE KATEGORIEN MERKMALE SORTIERTE UND TYPISIERTE MERKMALSTRUKTUREN SORTENHIERARCHIE SYNTAKTISCHE KATEGORIEN DAUGHTERS, HEADS UND DAS MERKMAL SUBCAT GRAMMATIK GRAMMATIK-PRINZIPIEN HEAD-FEATURE PRINZIP SUBKATEGORISIERUNGSPRINZIP WEITERE GRAMMATIK-PRINZIPIEN Das ID-Prinzip Das Marking-Prinzip Das Spec-Prinzip Das Nonlocal-Feature-Prinzip Das Trace-Prinzip Das Weak-Coordination-Prinzip Das Semantics-Prinzip Das Raising-Prinzip 20 2

3 3.2. GRAMMATIK-REGELN REGELSCHEMA 1 (HEAD-SUBJECT SCHEMA) REGELSCHEMA 2 (HEAD-COMPLEMENT SCHEMA) REGELSCHEMA 3 (HEAD-SUBJECT-COMPLEMENT SCHEMA) WEITERE REGELN Regel 4 (Head-Marker Schema) Regel 5 (Head-Adjunct Schema) Regel 6 (Head-Filler Schema) LEXIKON VERERBUNGSPRINZIPIEN LEXIKALISCHE REGELN ZUSAMMENFASSUNG BEHANDLUNG EINIGER PHÄNOMENE IN AGREEMENT KOMPLEMENTE UND ADJUNKTE SUBJEKTE UND PRÄDIKATE GRAMMATISCHE FUNKTIONEN WH-FRAGEN SATZFRAGEN HILFSVERBEN INVERSION SCHLUSSWORT BIBLIOGRAFIE 37 LITERATUR 37 VORLESUNGEN / SKRIPTS 37 HOMEPAGES 38 3

4 1. Einleitung Die Head-driven Phrase Structure Grammar, auf Deutsch Kopforientierte Phrasenstrukturgrammatik genannt, wurde erstmals 1985 von Carl Pollard präsentiert und 1987 im Buch Information-Based Syntax and Semantics, Volume 1: Fundamentals von Carl Pollard und Ivan Sag ausführlich vorgestellt. Bei der Head-driven Phrase Structure Grammar (nachfolgend mit abgekürzt) handelt es sich um eine generative Grammatiktheorie aus der Familie der Unifikationsgrammatiken. Unifikationsbasierte Grammatiktheorien wie die Phrasenstrukturgrammatiken werden auch constraint-basiert (bedingungsbasiert) genannt. Diesen Theorien eigen ist, dass sie linguistische Information u.a. mit Hilfe von Merkmalstrukturen repräsentieren. Die linguistische Information lässt sich auf einer Darstellungsebene (auf der Oberflächenstruktur) als deklaratives Wissen darstellen. Diese Darstellung auf einer Satzebene wird auch monostratale Repräsentation genannt; die Struktur eines Satzes besteht aus einem einzigen Syntaxbaum Vorläufertheorien verbindet Elemente aus der Categorial Grammar (CG, Kategoriale Grammatik), der Generalized Phrase Structure Grammar (GPSG), der Arc Pair Grammar (APG) und der Lexical-Functional Grammar (LFG) miteinander. Zum besseren Verständnis fügen wir hier kurze Definitionen dieser soeben erwähnten Vorläufertheorien an. Wir stützen uns hierbei vor allem Bussmann (1990) und Borsley (1997) Categorial Grammar Die Categorial Grammar wurde zwischen den beiden Weltkriegen von dem polnischen Logiker Ajdukiewicz entwickelt. In der Categorial Grammar hat die -Idee, dass 1 Für die computerlinguistische Forschung sind Phrasenstrukturgrammatiken (PSG s) die wohl bedeutendsten Syntaxtheorien. Werke zur Computerlinguistik wie die von Pereira und Shieber (1987) oder Alshawi (1992) stützen sich auf PSG s. 4

5 Kategorien Informationen darüber erhalten sollen, mit welchen anderen Kategorien sie kombinierbar sind, ihren Ursprung. 2 Alle Kategorien (abgesehen von einer kleinen Anzahl Basiskategorien) haben die Form α/β oder β/α, wobei α und β selbst Kategorien sind. Ein Ausdruck vom Format α/β verbindet sich mit einem ihm folgenden Ausdruck vom Format β zu einem Ausdruck vom Format α, und ein Ausdruck vom Format β/α verbindet sich mit einem ihm vorangehenden Ausdruck vom Format β zu einem Ausdruck vom Format α (so kann beispielsweise VP als NP/S dargestellt werden). Diese Kategorien werden nun als mathematische Funktionen aufgefasst. Da die Symbole als arithmetische Bruchzahlen interpretierbar sind, nennt man die oben vorgestellten Verbindungsmöglichkeiten auch Kürzungsregeln (α/β x β = α). Ist das Endresultat der Kürzungsregeln S, so handelt es sich um einen wohlgeformten Satz Generalized Phrase Structure Grammar (GPSG) Wie die ist auch die GPSG eine Unifikationsgrammatik. Sie wurde 1981/1982 von Gerald Gazdar entwickelt mit dem Ziel, der Transformationsgrammatik ein Modell entgegenzustellen, das formal eingeschränkter ist und mit einer einzigen Repräsentationsebene auskommt. Der Grammatikformalismus stellt ein komplexes System von Regeln und Bedingungen dar, die die Wohlgeformtheit der lokalen Bäume und damit die Grammatikalität des ganzen Satzes bestimmen. Die Phrasenstrukturregeln der GPSG entsprechen einer Version der X-Bar- Theorie; Metaregeln, die aus Phrasenstrukturregeln andere Phrasenstrukturregeln erzeugen, repräsentieren viele der syntaktischen Gesetzmässigkeiten, die in Transformationsgrammatiken durch Transformationen beschrieben sind (z. B. die Bildung von Passivsätzen). Jede Kategorie in der syntaktischen Struktur muss den Feature Coocurrence Restrictions und den Feature Specification Defaults genügen. Die Merkmalsweitergabe wird gesteuert durch drei globale Bedingungen: (a) Head Feature Convention 4, (b) Foot Feature Principle 5 und (c) Control Agreement Principle. 6 2 Dazu siehe Kap Borsley (1997), S Die Head Feature Convention entspricht dem Head Feature Principle in der ; siehe Kap

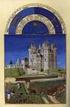

6 Arc Pair Grammar Die Arc Pair Grammar ist eine neuere Entwicklung der Relationalen Grammatik; letztere wurde als Modell einer Universalgrammatik von D. M. Perlmutter, P. M. Postal, D. E. Johnson u. a. entwickelt und stellt einen Gegenentwurf zur Transformationsgrammatik der sechziger Jahre dar. Die Relationale Grammatik geht von der Grundannahme aus, dass grammatische Relationen (wie Subjekt und Objekt) eine zentrale Rolle in der Syntax natürlicher Sprachen spielen und distanziert sich somit von anderen universalgrammatischen Modellen, die von Konstituentenstrukturbegriffen ausgehen. Die Relationale Grammatik vertritt die Meinung, dass grammatische Relationen nicht weiter analysierbare, primitive Konzepte sind, und dass syntaktische Konstituentenstruktur-Repräsentationen ungeeignet sind für die Beschreibung universeller Regularitäten. Sätze werden stattdessen mittels relationaler Netzwerke analysiert; diese Netzwerke enthalten einen Satzknoten, von dem Bögen für das Prädikat und dessen Argument ausgehen. Jedes abhängige Element steht auf jeder Beschreibungsebene in genau einer grammatischen Relation zu seinem regierenden Satzknoten. Die wichtigsten grammatischen Relationen sind (a) Subjekt (1-Relation), (b) direktes Objekt (2-Relation) und (c) indirektes Objekt (3-Relation). Konstituentenstruktur, lineare Abfolge und morphologische Markierung der Satzelemente werden nicht berücksichtigt. Abbildung 1 Abbildung 1 zeigt den Bogengraph für den Satz That book was reviewed by Louise, wobei c i und c j zwei syntaktische Ebenen darstellen. Die Ebene c i stellt den normalen, 5 Das Foot Feature Principle entspricht dem Nonlocal-Feature-Prinzip in der ; siehe Kap Genauere Informationen bietet das im Rahmen dieses Seminars geschriebene Skript zur Sitzung vom 13. April

7 unmarkierten, entsprechenden Aussagesatz dar, während Ebene c j die Umwandlung zum Passivsatz zeigt, wo die vorherige 1-Relation, das Subjekt, zum sogenannten Chômeur (Cho), also einem obliquen Partizipianten, demoviert wird Lexical-Functional Grammar (LFG) Die LFG ist eine generative Grammatiktheorie aus der Klasse der Unifikationsgrammatiken, die Ende der siebziger Jahre von J. Bresnan und R. Kaplan entwickelt wurde. Sie misst den grammatischen Relationen Subjekt, direktes/indirektes Objekt u. a. grosse Bedeutung bei. Die LFG geht davon aus, dass viele der syntaktischen Gesetzmässigkeiten, die in der Transformationsgrammatik durch Transformationen beschrieben wurden, lexikalischer Natur sind und daher auch nur im Lexikon repräsentiert werden können. Die LFG unterscheidet zwei Ebenen der syntaktischen Repräsentation; die C-Struktur 7 und die F-Struktur 8, die parallel von den Phrasenstrukturregeln erzeugt werden Merkmalstrukturen und Syntaktische Kategorien Kapitel 2 liefert eine Einführung in die grundlegenden Beschreibungsmittel von, die Merkmalstrukturen. Zuerst soll auf die Darstellung von Merkmalstukturen im Allgemeinen eingegangen werden (Repräsentation, Notation, hierarchische Gliederung), danach auf die für charakteristischen typisierten Merkmalstrukturen Merkmale In der sind alle linguistischen Einheiten durch Merkmalstrukturen (feature structures) repräsentiert. Der Einsatz von Merkmalstrukturen ist für Unifikationsgrammatiken sehr typisch, und in wird die Phrasenstruktur selbst 7 Die C-Struktur entspricht dem -Merkmal DTRS; siehe Kapitel Die F-Struktur entspricht dem -Merkmal SUBCAT; siehe ibid. 9 Für ausführlichere Erklärungen steht das Skript zur Sitzung vom 6. April 2000 zur Verfügung. 7

8 innerhalb einer Merkmalstruktur dargestellt. Diese Merkmalstrukturen werden nach Pollard / Sag (1988) Zeichen genannt und beinhalten 1. phonologische (PHON), 2. syntaktische (SYN) sowie 3. semantische (SEM) Informationen über Konstituenten. 10 Zeichen wird in diesem Kontext im Sinne Ferdinand de Saussures gebraucht und meint die Relation zwischen Form (signifiant) und Inhalt (signifié) eines linguistischen Ausdrucks. Als Zeichen betrachtet werden in jedoch nicht nur Wörter, Phrasen und Sätze, sondern auch ganze Diskurse. Die unterscheidet sich von anderen Syntaxtheorien dadurch, dass sie nur geordnete Merkmalstrukturen verwendet. Es werden keine anderen Beschreibungsmittel eingesetzt (wie bespielsweise in GPSG, deren ID-Schemata in Form von Phrasenstrukturregeln repräsentiert werden). Lexikoneinträge, Regeln und Prinzipien haben folglich gleichermassen die Form von geordneten Merkmalstrukturen. Häufig werden für die Darstellung von Merkmalstrukturen Matrizen (attributevalue matrices oder AVMs) gewählt. Bsp.: - - I cat NP I I agr [ num singular] I - - Man findet jedoch unter den Repräsentationsmitteln auch gerichtete Merkmalsgraphen (directed acyclic graph, DAG). Folgender DAG erfasst die Struktur des englischen Pronomens she Siehe dazu Kapitel Pollard / Sag (1994), S

9 Abbildung 2 Ausserdem werden in unifikationsgrammatische Beschreibungsmittel wie Disjunktion, Negation und Implikation als Werte von Merkmalstrukturen eingesetzt. So ist es praktischer, beispielsweise bei Lexikoneinträgen für englische Verben die gleichlautenden Formen in einem Eintrag zu erfassen und mit der Information nicht 3. pers. singular zu versehen, anstatt für jede Person einen eigenen Eintrag zu erstellen. Die Verwendung der Disjunktion lässt sich zum Beispiel mit Angaben zum deutschen bestimmten Artikel die motivieren. Er kann u.a. feminin singular und feminin plural im 9

10 Nominativ und Akkusativ sein, was einem Kasusmerkmal [kasus(nom OR akk)] entsprechen würde. Merkmale (attributes) müssen atomare Einheiten sein; Werte (values) jedoch sind atomar oder komplex, da sie wiederum aus Merkmalstrukturen bestehen können. benutzt als komplexe Erweiterungen von Merkmalstrukturen Mengen und Listen als Werte in Merkmalstrukturen. Diese unifikationsgrammatischen Beschreibungsmittel nennt man auch mengen- und listenwertige Merkmale (set values and list values); wie der Name es sagt, können diese Merkmale mehr als einen Wert besitzen. Zur Notation muss angefügt werden: { }: Mengenwertiges Merkmal. In einer Menge spielt die Reihenfolge der Merkmale keine Rolle. [ ]: Listenwertiges Merkmal. Geordnete Reihe von Merkmalen. <>: Notationelle Variante für listenwertige Merkmale (speziell für Valenz/Subkategorisierung). Häufig kommt es innerhalb einer Merkmalstruktur vor, dass zwei oder mehrere Merkmale die selbe Merkmalstruktur haben wie ihr Wert. Dieses Teilen der gleichen Werte nennt man Koreferenz oder structure-sharing (auch re-entrancy). Koreferenzen werden meist durch nummerierte Kästchen dargestellt, die auch tags genannt werden. 12 Koreferenzen repräsentieren also Dependenzen zwischen Konstituenten. Beispiel für zwei koreferente Merkmalsmatrizen: - - I cat S I I agr [1] [person 3] I I subject [agr [1] ] I - - ist identisch mit Wir verwenden jedoch auch die folgende Notation für Koreferenz: [1]. 10

11 I cat S I I agr [person 3] I I subject [person 3] I Sortierte und typisierte Merkmalstrukturen Merkmalstrukturen können also als Menge von Merkmal-Wert Paaren gesehen werden, wobei jedes Merkmal ein eindeutiges Symbol ist und jeder Wert entweder ein Symbol, ein Verweis oder selbst wieder eine Merkmalstruktur. Eine leere Merkmalstruktur kann als Variable interpretiert werden. 13 Eine typisierte (oder sortierte) Merkmalstruktur nun wird so definiert: A sorted feature structure consists of a set of features, where each feature consists of an attribute and a value. The attributes appropriate to a particular feature structure are determined by its sort. 14 Da es Abhängigkeiten zwischen gewissen Merkmalen gibt (das heisst, dass beispielsweise das Merkmal Kasus nur bei nominalen Kategorien auftritt), kann also bei bestimmten Kategorien die Einschränkung von Merkmalen gefordert werden: Man unterscheidet daher verschiedene Typen von Merkmalstrukturen. Beispiel: - - I cat NP I I agr [num singular] I I [person 3 ] I - - nominal Der Index (im Beispiel: nominal) am unteren Rand der Matrix bezeichnet den Typ (oder die Sorte) der Merkmalstruktur. Dieser Typ bestimmt, welche Merkmale innerhalb der Merkmalstruktur auftreten dürfen. Diese Typisierung bringt die Vorteile einer 13 Volk (1998) 14 Cooper (1996), S

12 zusätzlichen Kontrolle für die Wohlgeformtheit einer Merkmalstruktur sowie einer effizienteren Verarbeitung mit sich. In werden diese komplex erweiterten Strukturen typisierte (oder getypte) Merkmalstrukturen genannt. Zusammenfassend lässt sich über die typisierten Merkmalstrukturen in sagen: Jeder Knoten ist mit einem Typensymbol bezeichnet, das erklärt, was für ein Objekt die Struktur modelliert. Es gibt folglich ein Typensymbol für jede Art von Konstrukt. Die Typisierung zeigt an, welche Attribute in einer Merkmalstruktur erscheinen können, da nicht alle Merkmale zwingend auch für alle Typen relevant sind Sortenhierarchie Merkmalstrukturen in werden hierarchisch geordnet und über eine Vererbungsstruktur geregelt. Diese Struktur wird Sorten- oder Typenhierarchie (sort hierarchy) genannt: Das heisst, wenn zwei typisierte Merkmale unifiziert werden, so ist der Typ der resultierenden Merkmalstruktur der nächst allgemeinere Typ in der Hierarchie. Ein Übertyp gibt an, welche Merkmale für alle seine Untertypen gelten; dabei kann jeder Untertyp weitere Merkmale hinzufügen. Unterknoten erben also die Merkmale von ihnen übergeordneten Knoten. Dabei gelten die für Konstituentenstrukturen üblichen Gesetze der (unmittelbaren) Dominanz sowie der (unmittelbaren) Konstituenz. Die hierarchische Ordnung von Typen erlaubt es, Generalisierungen über die einzelnen Typen zu formulieren. Dies ist bei einer Implementierung effizienzsteigernd, da die Generalisierungen die Grammatik um ein Vielfaches verkleinern Syntaktische Kategorien Wie schon in Kapitel 2.1. erwähnt, sind syntaktische Kategorien in komplexe Einheiten (Merkmalstrukturen), welche wiederum aus kleineren Elementen (auch Merkmalstrukturen oder atomaren Merkmalen, d.h. Symbolen oder Attributen) bestehen. Im Folgenden wird eine Konstituente in, eine Merkmalstruktur des Typs Zeichen, näher erklärt. Wie schon erläutert, werden Zeichen als strukturierte Komplexe 12

13 von phonologischer, syntaktischer, semantischer und phrasenstrukturierter Information aufgefasst. Dabei gilt (erläutert sei eine kleine Auswahl): Abbildung 3 PHON: Die phonologische Repräsentation PHON eines Zeichens besteht aus einem Wert, welcher in einer Liste die phonologische Struktur der Konstituente erfasst. Die Merkmalsrepräsentation des Lautgehalts eines Zeichens dient als Basis für phonologische und phonetische Interpretation. SYNSEM: Der Wert des SYNSEM Attributes kodifiziert die syntaktische und semantische Information einer Konstituente. Das Symbol SYNSEM wird weiter unterteilt in die komplexen Merkmalstrukturen LOCAL und NONLOCAL. LOCAL: Das Merkmal LOCAL beinhaltet CATEGORY (mit HEAD, SUBCAT und LEX), CONTENT und CONTEXT. CATEGORY: Zu HEAD und SUBCAT: Siehe Kapitel LEX: LEX ist ein binäres Attribut, welches beschreibt, ob eine Einheit lexikalisch ist (+) oder nicht (-). CONTENT und CONTEXT: Beinhalten semantische Informationen Die stützt ihre Darstellung von semantischer Information auf die Situationssemantik. Die Situationssemantik basiert auf der Annahme, dass es eine einzige Welt gibt, über die gültige Aussagen über darin vorkommende Situationen gemacht werden können. Dabei gilt: Meaning is analysed as a 13

14 NONLOCAL: Wird bei der Behandlung ungebundener Dependenzphänomene eingesetzt. NONLOCAL enthält weiter INHERITED und TO-BIND. TO-BIND besteht jeweils aus SLASH (beschreibt wh-abhängigkeiten), QUE (zeigt an, wo die Fragewörter in einem Satz stehen) und REL (markiert die Stellung von Relativpronomen). Die mengenwertigen Merkmale SLASH, QUE und REL sind bei Aussagesätzen mit kanonischer Wortstellung folglich leer. (...) Von einer Beschreibung der weiteren Einteilungen sei hier abgelassen, da die verschiedenen Autoren (Pollard / Sag, Borsley, Cooper) in ihren Bezeichnungen und Erklärungen stark voneinander abweichen oder sich nicht auf eine Darstellung festlegen Daughters, Heads und das Merkmal Subcat Da in Merkmalstrukturen sowohl als Abbildung von Satzkonstituenten als auch von lexikalischen Konstituenten eingesetzt werden können, müssen Satzkonstituenten besonders gekennzeichnet werden: Das Symbol Daughters (DTRS) erfüllt diese Funktion und benennt Zeichen, die Phrasen beschreiben. Die DTRS sind daher die einzelnen Bestandteile eines komplexen Ausdrucks (Bsp.: DTRS der NP the house sind ein Det the und ein N house). Meist ist das Symbol Daughters wiederum eine komplexe Merkmalstruktur und unterscheidet die HEAD-DTR von den COMP-DTRS. COMP-DTRS steht für complement daughters und ist eine Liste mit Beschreibungen von Merkmalstrukturen, in der jedes Element ein Komplement beschreibt. 16 In bildet per definitionem die Verbalphrase die HEAD-DTR eines Satzes. Als Kopftochter von S wird folglich VP behandelt, nicht die Subjekts-NP. Da der Kopf als das obligatorische Element einer Phrase betrachtet wird, liefern zum Beispiel Imperativsätze, in denen kein Subjekt steht, oder Sätze mit disloziertem Subjekt (wie nachfolgendes Beispiel) Evidenz für diese Ansicht. relation between situation types, and linguistic meaning relates utterance situation types to described situation types. Weitere Informationen in Borsley (1996), S Das Attribut DTRS entspricht ungefähr der c-struktur in LFG. 14

15 Beispiel: Who do you think [ _ will win the race?] Das Merkmal SUBCAT regelt die Subkategorisierung. Dieses Merkmal erhält nach Pollard / Sag (1994) 17 als Wert eine Liste mit sämtlichen Komplementen (nämlich SYNSEM-Objekten). Das Subjekt steht ebenfalls in dieser Liste. Das Merkmal SUBCAT besagt folglich, was für ein Subjekt und was für Komplemente ein Ausdruck benötigt. Beispiel (nach Borsley 18 ): V[SUBCAT=< >] --> sleep V[SUBCAT=<NP>] --> see V[SUBCAT=<PP>] --> wait V[SUBCAT=<NP, PP>] --> put Man beachte, dass in dieser Repräsentation - ganz im Gegensatz zur obigen Behauptung - das Subjekt nicht in der SUBCAT-Liste erscheint. Dies liegt daran, dass in verschiedenen Varianten der für das Subjekt eine eigene SUBCAT-Liste eingeführt wird; diese Behandlung des Subjekts berücksichtigt die Tatsache, dass Subjekte gegenüber anderen Komplementen jeweils spezielle Stellungen einnehmen. Es wird in demnach manchmal mit zwei verschiedenen SUBCAT-Listen operiert, wobei in der einen (siehe oben eingeführtes Beispiel) nur mehr die Komplemente des Verbs erscheinen. Nach Pollard / Sag (1994) wird das Subjekt in die SUBCAT-Liste aufgenommen und über das Subkategorisierungsprinzip (dazu Kapitel ) abgearbeitet. Im Gegensatz zu den Komplementen ist das Subjekt nicht Geschwister-Knoten zum Verb, sondern es wird in einem zweiten Schritt abgearbeitet. 19 Die SUBCAT-Liste ist geordnet; die Reihenfolge der darin vorkommenden Elemente wird durch den Grad 17 Wir beziehen uns, falls nicht anders vermerkt, auf Pollard / Sag (1994), nicht auf deren erste Version einer (Pollard / Sag (1987)). 18 Borsley (1997), S Pollard / Sag (1994), S

16 ihrer obliqueness bestimmt, das heisst, dass das am wenigsten oblique Element zuerst kommt. 20 Das Attribut SUBCAT zeigt den Grad der Sättigung eines Zeichens. Erst dann, wenn unter SUBCAT die leere Liste (< >) steht, sind alle Komplemente abgearbeitet worden; das Zeichen ist gesättigt. 3. Grammatik besteht aus Grammatik-Prinzipien, Grammatik-Regeln und Lexikon-Einträgen, welche alle durch Merkmalstrukturen repräsentiert werden. Jede zulässige Konstituente wird von einer Merkmalstruktur beschrieben; diese Merkmalstruktur muss gleichzeitig von jedem Grammatik-Prinzip subsumiert werden sowie entweder von einer Grammatik-Regel (wenn die Konstituente eine Phrase ist), oder von einem Lexikon- Eintrag (wenn die Konstituente lexikalisch ist). Alle diese Merkmalstrukturen müssen notwendigerweise von der Sorte Zeichen sein. 21 besteht also aus: 1. Grammatik-Prinzipien, 2. Grammatik-Regeln (Immediate Dominance-Regeln), 3. Lexikon-Einträgen. Da der -Formalismus stark lexikalisiert ist (das heisst, dass das Lexikon einen grossen Teil der grammatischen und syntaktischen Information enthält), sind die Grammatikregeln und -prinzipien auf ein Minimum reduziert Grammatik-Prinzipien besteht aus allgemeinen und - falls nicht explizit als sprachspezifisch deklariert - universell gültigen Grammatikprinzipien. Jede wohlgeformte Merkmalstruktur vom Typ Zeichen muss von diesen Prinzipien subsumiert werden. 20 Dazu Cooper (1996), S. 193: [...]Obliqueness is a function of grammatical relation: subjects are less oblique than direct objects, which are in turn less oblique than indirect objects. 21 Nach Cooper (1996), S

17 Head-Feature Prinzip Das Head Feature-Prinzip stellt sicher, dass einem Kopf und seiner phrasalen Projektion die Head Features gemeinsam sind. In Borsley s Worten: The HEAD value of a headed phrase is identical to the HEAD value of the head daughter. 22 In Form einer Merkmalstruktur sieht das Head Feature-Prinzip folgendermassen aus: DTRS headed-structure [ ] -----> SYNSEM LOCAL CATEGORY HEAD [1] DTRS HEAD-DTR SYNSEM LOCAL CATEGORY HEAD [1] - - Abbildung 4 Abbildung 4 ist eine vereinfachte Darstellung: Es werden nur die Pfade zu den interessierten Werten gezeigt (vergleiche Abbildung 3). Was man also hier sieht ist der Weg über die Merkmale, die man in einer vollständigen Merkmalstruktur gehen müsste, um zu diesem bestimmten Merkmal HEAD und seinem Wert zu gelangen. Das Head Feature-Prinzip besagt also, dass jede Merkmalstruktur, in der das Merkmal DTRS vorkommt - und zwar mit einer Merkmalstruktur vom Typ headedstructure als Wert - mit der Konsequenz dieser Implikation unifiziert werden muss. Die 22 Borsley (1996), S Anmerkung: Zur Vereinfachung der Darstellung können komplexe Merkmalstrukturen durch Pfade ersetzt werden. Bsp.: A B C ist gleichbedeutend mit [A[B[C]]]. 17

18 Konsequenz besagt mit Hilfe von Koreferenzsymbolen, dass das HEAD-Merkmal der Mutter und das HEAD-Merkmal der Tochter (HEAD-DTR) referenz-identisch sein müssen. Eine graphische Darstellung desselben Prinzips sieht aus wie folgt (dabei steht δ für die HEAD-DTR): 24 Abbildung Subkategorisierungsprinzip Das Subkategorisierungsprinzip wird auch Valenzprinzip genannt. Es sorgt dafür, dass ein Satz (respektive ein Verb) die korrekte Anzahl und Art von Komplementen erhält. Es lässt sich wie folgt formulieren: Wenn ein Kopf und seine Mutter unterschiedliche Werte für [das Merkmal] SUBCAT haben, dann müssen die Kategorien, die in der SUBCAT-Liste des Kopfes, nicht jedoch die, die in der SUBCAT-Liste der Mutter stehen, mit den Schwestern des Kopfes identisch sein. 25 Cooper beschreibt das Subkategorisierungsprinzip so:...for any headed phrase, the subcategorization requirements of the phrase are those of the head daughter less those filled by any complement daughters. 26 Graphisch dargestellt sieht dies etwa so aus: 24 Sag / Wasow (1999) 25 Borsley (1997), S Cooper (1996), S

19 Abbildung Weitere Grammatik-Prinzipien Es existieren einige weitere universelle Grammatikprinzipien, deren einzelne Behandlung den Rahmen dieser Arbeit jedoch übersteigen würde. Es folgt daher nur eine kurze Skizze ihrer jeweiligen Verwendungszwecke Das ID-Prinzip Jede headed phrase muss genau einer der Immediate Dominance Regeln (ID- Regeln) 27 genügen Das Marking-Prinzip Das Marking-Prinzip kommt bei mit that, for u.ä. eingeleiteten Komplementsätzen zum Zuge Das Spec-Prinzip Das Spec-Prinzip wird zur Behandlung von Quantifikatoren und Possessivphrasen eingesetzt. 27 Siehe dazu Kapitel

20 Das Nonlocal-Feature-Prinzip Das Nonlocal-Feature-Prinzip ist die -Entsprechung zum Foot-Feature-Prinzip in GPSG und behandelt ungebundene Dependenzphänomene Das Trace-Prinzip Das Trace-Prinzip wird ebenfalls bei ungebundenen Dependenzphänomenen angewendet; es setzt Bedingungen für die Verwendung von Traces Das Weak-Coordination-Prinzip Das Weak-Coordination-Prinzip regelt das Verhältnis zwischen koordinierten Töchtern und deren Mutterknoten Das Semantics-Prinzip Das Semantics-Prinzip ist eine Kombination aus drei einzelnen Prinzipien: Dem Content-Prinzip, dem Quantifier-Inheritance-Prinzip und dem Scope-Prinzip. Es ist für die Semantikkomponente zuständig, die in dieser Arbeit allerdings bewusst vernachlässigt wird Das Raising-Prinzip Anders als die vorhergehenden Prinzipien, die Bedingungen an Merkmalstrukturen stellen, ist das Raising-Prinzip eine Einschränkung der Form von Lexikoneinträgen. Dieses Prinzip behandelt Raising-Konstruktionen Grammatik-Regeln Obwohl als Phrasenstrukturgrammatik gilt, werden Regeln nicht mit formalen Rewrite Rules dargestellt wie in anderen Grammatiken. Da Phrasenstrukturbäume und phrasale Konstituenten in Merkmalstrukturen kodiert sind, werden Grammatikregeln als 20

21 Bedingungen für deren Wohlgeformtheit formuliert: Jede Grammatikregel hat die Form einer Merkmalstruktur und jede Struktur, die eine Phrase beschreibt, muss von einer Grammatikregel subsumiert werden. Die Grammatikregeln in werden Immediate Dominance-Regeln (ID-Schemata oder Phrase Structure-Regeln) genannt und dienen eigentlich als Templates 28 für zulässige lokale Phrasenstrukturbäume; sie lehnen sich also an die Regeln der X-bar Theorie an. Der stark lexikalische Charakter der hat zur Folge, dass nur sehr wenige, schematische Immediate Dominance Templates (Regelschemata) übrig bleiben. Tatsächlich wird die -Grammatik grösstenteils von nur zwei Regeln abgedeckt (Regeln 1 und 2, die im Folgenden dargestellt werden) Regelschema 1 (Head-Subject Schema) Das Regelschema 1, das der Aufgabe der Specifier-Regel aus der X-bar Theorie nachkommt, besagt, dass eine saturierte Phrase aus einem nichtlexikalischen Kopf und einem einzigen Komplement bestehen kann. In Form einer Merkmalstruktur sieht dies wie folgt aus: 29 Abbildung 7 Dem Subkategorisierungsprinzip entsprechend muss der Kopf einer solchen Phrase genau ein Komplement erfordern; dieses Komplement muss mit dem Element in der Komplement-Tochter-Liste (COMP-DTRS) identisch sein. Pollard / Sag definieren das Regelschema 1 als a saturated ([SUBCAT < >]) phrase with DTRS value of sort head-comp-struc in which the HEAD-DTR value is a phrasal sign and the COMP-DTRS value is a list of length one. 30 In ihrer Darstellung: Templates (englisch Muster oder Schablone ) sind deklarierte Merkmalstrukturen, die über ihren Namen innerhalb anderer Merkmalstrukturen aufgerufen werden können. 29 Vergleiche dazu Pollard / Sag (1994), S

22 Abbildung 8 Das Regelschema 1 lizenziert folglich gesättigte Phrasen mit einer phrasalen Kopftochter und einer weiteren Tochter, die Komplement ist. Als direkte Konsequenz des Subkategorisierungsprinzips muss der Wert des SYNSEM-Merkmals der Komplement-Tochter identisch mit dem einzigen Element in der SUBCAT-Liste der Kopftochter sein; ausserdem muss dieses Element das Subjekt (das am wenigsten oblique Element der SUBCAT-Liste) des lexikalischen Kopfes sein. Dieses Regelschema deckt die gängigen Phrasenstrukturregeln S --> NP VP (wobei VP der Kopf von S ist) 32, NP --> Det Nom oder NP --> NP[Gen] Nom ab. In der X-Bar-Theorie wird dasselbe so ausgedrückt: X --> Spec X Regelschema 2 (Head-Complement Schema) Das Regelschema 2, das der Komplement-Regel in der X-bar Theorie entspricht, besagt, dass eine Phrase aus einem (nichtinvertierten) lexikalischen Kopf zusammen mit allen seinen Komplementen ausser dem am wenigsten obliquen bestehen kann. In Form einer Merkmalstruktur wiederum sieht dieses Regelschema so aus: ibid., S ibid., S Man beachte: Das Subjekt wird hier als Komplement und somit Element der SUBCAT-Liste betrachtet. 33 Cooper (1996), S

23 Abbildung 9 Das Regelschema 2 beschreibt eine wohlgeformte Phrase also auch so: An almost-saturated (SUBCAT list of lengh one) phrase with DTRS value of sort head-comp-struc in which the HEAD-DTR value is a lexical sign. 34 Die Abbildung 9 ist daher gleichbedeutend mit folgender Notationsweise 35 : Abbildung 10 Das Regelschema 2 subsumiert folglich alle konventionellen Phrasenstrukturregeln, die eine Phrase als lexikalischen Kopf mit seinen Komplementen (ausser dem am wenigsten Obliquen, also dem Subjekt) expandieren; es sind dies sowohl alle VP- Regeln als auch Regeln für die Modifikation von Nomen mit Nondeterminier- 34 Pollard / Sag (1994), S Pollard / Sag (1994), S

24 Komplementen. 36 Die entsprechende Regel aus der X-Bar-Theorie wird so ausgedrückt: X --> X Comp*. Die -Spezifikation lässt offen, ob alle Komplementsvalenzen auf einmal gesättigt werden oder ob sie schrittweise abgearbeitet werden. Das Regelschema 2 ist die vielleicht wichtigste syntaktische Grundregel Regelschema 3 (Head-Subject-Complement Schema) Das Regelschema 3 beschreibt eine wohlgeformte Phrase als a saturated ([SUBCAT <>]) phrase with DTRS value of sort head-comp-struc in which the HEAD-DTR value is a lexical sign 37. Graphisch dargestellt: Abbildung 11 Als Konsequenz des Head-Feature Prinzips stellt die generelle Form von Regelschema 3 eine Phrase dar, in der alle Komplemente (einschliesslich dem Subjekt) als Schwestern des lexikalischen Kopfes realisiert werden. 36 Nondeterminer-Komplemente sind solche, die nicht in Determinerstellung auftreten, also nicht Subjekt sind. 37 Pollard / Sag, S

25 Diese Regel kommt bei Sprachen mit freier Konstituentenordnung zum Zuge (in der deutschen Sprache beispielsweise, wo die Komplemente mehr oder weniger frei angeordnet werden können, mit der Einschränkung, dass das Verb je nach Satzart satzinitial oder satzfinal stehen muss). Auch die Subjekt-Auxiliar-Inversion im Englischen wird so behandelt Weitere Regeln Pollard / Sag führen drei weitere Grammatikregeln auf. An dieser Stelle seien nur kurz ihre jeweiligen Verwendungszwecke erwähnt Regel 4 (Head-Marker Schema) Regel 4 wird bei mit that und for eingeleiteten Komplementsätzen wie I know [that John left] angewendet Regel 5 (Head-Adjunct Schema) Pollard / Sag gehen davon aus, dass Adjunkte ihren zugehörigen Kopf selektieren. Schema 5 regelt die Art und Weise, in der ein Adjunkt und der Kopf, den es selektiert, kombiniert werden können Regel 6 (Head-Filler Schema) Regel 6 kommt bei ungebundenen Dependenzphänomenen zum Einsatz Lexikon Das Lexikon beinhaltet in die meisten syntaktischen Informationen; es ist äusserst reich an Einträgen und sehr komplex. Trotzdem, so betont Borsley, ist das Lexikon in nicht überladen, denn es wird in Vererbungshierarchien strukturiert Borsley (1996), S. 38f. 25

26 Das heisst, das Lexikon wird von verschiedenen Vererbungsprinzipien organisiert, welche die Lexikon-Einträge um ein Vielfaches reduzieren. Das -Lexikon kann folglich nicht als unstrukturiertes Set von Wort-Merkmalstrukturpaaren angesehen werden. Das Lexikon in besteht einerseits aus Hierarchien, die Merkmale vererben, und andererseits aus lexikalischen Regeln Vererbungsprinzipien Die ursprünglich für Wissensrepräsentationen im Gebiet der Künstlichen Intelligenz verwendeten Vererbungshierarchien dienen in dazu, die lexikalischen Einträge einer gleichen Sorte unter einem einzigen Gattungseintrag zusammenzufassen. Als veranschaulichendes Beispiel nennt Borsley 39 das Wort gives: gives teilt seine Eigenschaft 3. pers. sg. präsens, ditransitiv einerseits mit allen Verben der Form 3. pers. sg. präsens sowie, andererseits, mit allen ditransitiven Verben. Somit können sämtliche Verben der Form 3. pers. sg. präsens, ditransitiv in nunmehr zwei Gattungseinträgen erfasst werden. Der lexikalische Eintrag eines Wortes give besteht daher aus 1. einem Verweis auf diese beiden Gattungseinträge, und 2. den dem Wort eigenen phonologischen und semantischen Informationen. Des Weiteren gilt, dass in die Gattungseinträge lexikalische Sorten sind und somit auch zur Vererbungsstruktur der der -Grammatik eigenen Vererbungshierarchie gehören. Jeder lexikalische Eintrag ist in allen relevanten Hierarchien (der Grammatik, des Lexikons) nach grammatischen Kriterien kreuzklassifiziert. Die Knoten oder Verzweigungsstellen einer jeden Hierarchie entsprechen typisierten Merkmalstrukturen, und die Abhängigkeiten - die Dominanzrelationen - innerhalb der Hierarchie sind mit Subsumptionsrelationen zu vergleichen. Jeder Mutterknoten gibt also an, welche Merkmale auf alle seine Töchter zutreffen, und jede Tochter kann weitere Merkmale hinzufügen. 39 ibid., S

27 Dieser Ansatz vermindert Redundanz im Lexikon. Die Organisation des - Lexikons erlaubt daher Verallgemeinerungen, welche die Anzahl der Einträge verringern Lexikalische Regeln Weitere Generalisierungen, nämlich solche zwischen einzelnen Formen eines Wortes, werden durch lexikalische Regeln ausgedrückt. Eine lexikalische Regel für das Passiv beispielsweise verbindet Merkmalstrukturbeschreibungen von verbalen Grundformen mit Beschreibungen ihrer Passivpartizipien Beispiel 40 : Abbildung 12 Gewisse lexikalische Regeln sind für die Bildung von flektierten Verbformen wie 3. pers. sg. aus Infinitiven zuständig: Beispiel 41 : walks aus walk 40 Schneider (1999), Skript zum Passiv. 41 Schneider (1999), Skript zum Passiv. 27

28 Abbildung 13 Andere lexikalische Regeln stellen Relationen zwischen allen Verbformen, verschiedenen Adjektivformen und nominalen Pluralformen her. Lexikalische Regeln in sollen also in erster Linie aus Basisformen flektierte Formen bilden. Mit Hilfe solcher Regeln kann nun das Lexikon ausschliesslich in Basisformen gehalten werden. Die Abarbeitung kann vor dem Parsing (offline) oder auch während dem Parsing (online) erfolgen. Eine offline-abarbeitung bedeutet, dass der Parser schon von Anfang an mit einem Vollformenlexikon arbeitet und keine morphologischen Schritte mehr durchführt. Dem Geschwindigkeitsvorteil steht ein exponentiell gewachsenes Lexikon gegenüber. Gewisse derivationale Morphologieprozesse wie Nominalkomposition lassen sich für umfassende Grammatiken jedoch nur online durchführen Zusammenfassung Die Grammatik in fungiert als Beschränkung für die linguistische Wohlgeformtheit der vorkommenden Zeichen. Das heisst, dass jedes wohlgeformte Zeichen mit der Grammatik unifizierbar sein muss: Unifikation operiert über 28

29 Merkmalstrukturen. Die Gesamtheit der korrekten Sätze in einer -Grammatik lässt sich mit der folgenden Formel erfassen: 42 P 1 unifiziert mit... unifiziert mit P l unifiziert mit (R m v... v R n v L 1 v... v L n ) wobei gilt: P i R i Li sind die Grammatik-Prinzipien sind die Grammatik-Regeln sind die lexikalischen Einträge v Disjunktion Die Grammatik in ist folglich die Disjunktion aller Regeln und aller lexikalischen Einträge, in Konjunktion gesetzt (unifiziert) mit den grammatischen Prinzipien. 4. Behandlung einiger Phänomene in Im Hinblick auf die später (im zweiten Teil unserer Arbeit in Zusammenhang mit der Grammatik LinGO) behandelten Beispielsätze erscheint es angemessen, hier einige -Lösungsansätze theoretisch vorzustellen Agreement Pollard / Sag sehen Strukturen, die infolge von Kongruenzphänomenen identisch sein müssen als koindexiert an. Es wird also ein Merkmal INDEX benötigt. Die Form des Verbes zum Beispiel wird eingeschränkt, wenn die Grammatik Koreferenz zwischen dem Wert seines Merkmals INDEX mit einem von einem anderen Ausdruck festgelegten Index verlangt. 42 Cooper (1996), S Wir stützen uns dabei auf Borsley (1997). 29

30 4.2. Komplemente und Adjunkte Die Unterscheidung zwischen Komplementen und Adjunkten ist für alle Kategorien relevant; im Folgenden wird sie jedoch nur im Zusammenhang mit Verben erläutert werden. Komplemente sind mit spezifischen lexikalischen Köpfen auf eine Weise verknüpft, wie dies für Adjunkte nicht gilt: Bestimmte lexikalische Köpfe erscheinen gleichzeitig mit bestimmten Komplementen, während Adjunkte eines bestimmten Typs generell in jeder Phase möglich sind - unabhängig davon, was deren Kopf ist. Ausserdem tendieren Komplemente dazu, obligatorisch zu sein, während Adjunkte immer optional sind. Beispiel: Optionales Komplement Stefan was eating [the carrot]. Es wird allgemein angenommen, dass es einen strukturellen Kontrast zwischen Komplementen und Adjunkten gibt. Speziell geht man davon aus, dass Komplemente mit einer lexikalischen Kategorie verbunden sind und mit ihr eine verwandte intermediäre Kategorie bilden. Adjunkte hingegen verbinden sich mit einer beliebigen Kategorie und formen nur wieder eine Kategorie des gleichen Typs. Beispiel: Borsley (1997), S

31 Abbildung 14 benutzt zur Behandlung solcher Phänomene das Merkmal SUBCAT, das eine Liste von Kategorien als Wert annimmt. 45 Die SUBCAT-Liste soll genau jene Komplemente einschliessen, die der lexikalische Kopf fordert. Ist der Wert von SUBCAT eine leere Liste, so werden keine Komplemente gefordert bzw. zugelassen. Abgearbeitet wird die SUBCAT-Liste in Interaktion mit der Head-Complement-Regel 46 und dem Subkategorisierungsprinzip 47. Für Adjunkte hingegen wird ein Head-Feature MODIFIED (MOD) eingeführt, worin die Werte für die Merkmale INDEX und REST mit denen der Adjunkttochter übereinstimmen müssen. Den verschiedenen Methoden zur Behandlung von Adjunkten wird in grosse Beachtung geschenkt; es ist jedoch auch heute noch unklar, welche Analyse für Adjunkte korrekt ist Subjekte und Prädikate Im Englischen, Deutschen sowie in vielen anderen Sprachen besteht ein typischer Satz aus einem Subjekt und einem Prädikat. In der gleichen Weise, in der lexikalische Köpfe bestimmte Komplemente nehmen, verbinden sich Prädikate mit bestimmten Subjekten. Pollard / Sag behandeln Subjekte als die Realisierungen einer weiteren Kategorie in der SUBCAT-Liste. Dies ist der Grund, weshalb die Head-Complement- Regel ausschliesst, dass ein Kopf sich mit allen Kategorien seiner SUBCAT-Liste verbindet: Die letzte Kategorie der SUBCAT-Liste, das Subjekt, ist von der Verbindung mit dem Kopf ausgenommen. Diese letzte Kategorie erscheint als die SUBCAT-Liste des Mutterknotens. Für die Verbindung von Subjekt und Prädikat wird nun eine Regel 45 Vergleiche dazu Kapitel Siehe Kapitel Siehe Kapitel Neben dem eben vorgestellten Lösungsansatz existieren u.a. auch Methoden, welche Adjunkte als Schwestern von Komplementen behandeln. In diesem Ansatz wird man den im Englischen selten auftretenden Fällen von Adjunkten, welche Komplementen vorangestellt sind (Bsp.: Sandy thought until she met him that Kim was too old), gerecht. Dazu Borsley (1996), S

32 benötigt, die eine VP-Kategorie, welche ein einziges Element, das Subjekt, in ihrer SUBCAT-Liste fordert, mit einem entsprechenden Element des Kontextes verbindet, das Head-Subject Schema. Expletiva (dummy it/es) werden von PS-Grammatiken nicht gesondert behandelt, sondern generell als Dummies für Subjekte behandelt und von normalen NPs durch ein Merkmal NFORM unterschieden, das als Wert NORM, THERE/DA und IT/ES hat Grammatische Funktionen Mit grammatischen Funktionen/Relationen sind Begriffe wie Subjekt und Objekt gemeint. In der von Pollard / Sag (1994) beschriebenen -Version wird das Subjekt als Realisierung einer zusätzlichen Kategorie der SUBCAT-Liste verstanden, in anderen Versionen als Realisierungen eines separaten SUBJ-Merkmals. In ersterer Version könnte ein Subjekt wie folgt definiert werden: Ein Subjekt ist ein Ausdruck, der das letzte Element in einer SUBCAT-Liste realisiert. 49 Wenn nun Subjekte die Realisierungen einer zusätzlichen Kategorie in der SUBCAT- Liste sind, dann können nominale Objekte wie folgt definiert werden: Ein Objekt ist eine NP, die die vorletzte Kategorie in der SUBCAT-Liste eines Verbs realisiert Wh-Fragen Wh-Fragen sind Satztypen, in denen ein Komplement oder ein Subjekt fehlt. In den PS- Grammatiken wird generell ausgesagt, dass sie leere Kategorien wie die Spuren (traces) in der GB-Theorie aufweisen. 49 Borsley (1997), S ibid., S

33 Abbildung 15 Wenn man eine solche Struktur annimmt, muss man die leere Kategorie sensitiv machen für die Anwesenheit der wh-phrase weiter oben im Baum. Wie in GPSG wird zu diesem Zwecke auch in ein Merkmal SLASH eingeführt. Dieses Merkmal nimmt eine Kategorie als Wert und zeigt an, dass eine Konstituente eine leere Kategorie bestimmter Art enthält. Der vorher eingeführte Baum kann also wie folgt erweitert werden: Borsley (1997), S

34 Abbildung 16 Es muss nun noch eine Regel eingefügt werden, die solche Strukturen lizenziert Satzfragen Die Behandlung von Satzfragen lässt sich in zwei Teilgebiete gliedern: Die Behandlung von Hilfsverben und der Subjekt-Verb-Inversion Hilfsverben Es lassen sich einige Generalisierungen über Hilfsverben zusammenfassen: Sie sind optional. 2. Sie determinieren die Form des folgenden Verbs. 3. Mehrere Auxiliare können gemeinsam stehen, allerdings nur in einer bestimmten Reihenfolge. 4. Hilfsverben eines bestimmten Typs können sich nicht wiederholen. Während sich Borsley 53 über die allgemeine Betrachtung von Auxiliaren weitgehend ausschweigt, bieten Sag / Wasow folgende Analyse an: Sie betrachten Hilfsverben generell als Verben, die VP-Komplemente verlangen, ein Ansatz, der das Problem der zweiten Generalisierung sehr elegant löst, während (beinahe) die gesamte restliche Information im Lexikoneintrag des jeweiligen Hilfsverbs enthalten ist. Satzfragen, in denen kein Auxiliar vorhanden ist, werden bekanntlich mit do konstruiert. Der von Sag / Wasow vorgeschlagene Lexikoneintrag für do sieht so aus: 52 Nach Sag / Wasow (1999). 53 Borsley (1997). 34

35 Abbildung 17 Diese Merkmalstruktur sagt unter anderem aus, dass der Kopf des Komplements von do ein Infinitiv sein muss, aber kein Hilfsverb sein kann, und dass das Auxiliar do selbst nur in finiten Formen auftritt. Der Semantikwert ausserdem garantiert, dass do keinen Beitrag an die Semantik des Satzes leistet Inversion In Satzfragen steht das Auxiliar vor dem Subjekt. Trotzdem soll die Beziehung zwischen dem Hilfsverb und seinem Komplement, dem Hauptverb, erhalten bleiben. Das Problem besteht also darin, das Subjekt hinter dem Auxiliar zu positionieren. Sag / Wasow schlagen dazu vor, die postauxiliare NP (also das Subjekt) nicht als Specifier, sondern vielmehr als erstes Komplement des Hilfsverbs zu behandeln. Da das Head- Complement Schemata Komplemente in der Reihenfolge, in der sie in der SUBCAT- Liste des Kopfes stehen, realisiert, erscheint die Subjekts-NP als erstes Komplement im Lexikoneintrag für das invertierte Auxiliar im Fragesatz an der richtigen Stelle. Es muss also nur noch eine lexikalische Regel für YES-NO-Fragen formuliert werden, die die Subjekt-Verb-Inversion erst bewirkt. 35

36 5. Schlusswort In den letzten Jahren hat sich in der Computerlinguistik zum einflussreichsten Framework für die deklarative Spezifikation von Grammatik entwickelt. Es arbeiten mehr Leute an und mit implementierten -Grammatiken als mit jedem anderen linguistischen Grammatikmodell. Welches sind denn die entscheidenden Vorteile von? Besser als in anderen grammatischen Frameworks können linguistische Generalisierungen isoliert und doch uniform in Prinzipien repräsentiert werden. Der -Formalismus lässt für eine konkrete Implementation relativ viel Freiheit, weshalb auch zahlreiche Versionen (von denen wir uns auf die von Pollard / Sag in 1994 und von Borsley in 1996 Präsentierten gestützt haben) in Gebrauch sind. Ebendiese Freiheit jedoch erschwert es, die essentiellen Eigenschaften von -Grammatikmodellen, Implementationen von -Formalismen oder konkret sprachspezifischen -Grammatiken zu ermitteln. Dies muss allerdings nicht unbedingt als Nachteil betrachtet werden, da gerade diese Konstellation Raum für weitere, innovative Entwicklungen in verschiedene Richtungen schafft. Ausserdem wurde von Anfang an bewusst darauf ausgerichtet, ein präzises Framework zur Artikulation einer Synthese von Ideen aus Grammatiken unterschiedlichster Traditionen zu bilden. 36

37 6. Bibliografie Literatur Borsley, Robert D.: Modern Phrase Structure Grammar. Oxford: Blackwell Publishers, Borsley, Robert D.: Syntax-Theorie. Ein zusammengefasster Zugang. Dt. Bearb. v. P. Suchsland. Tübingen: Niemeyer, (Konzepte der Sprach- und Literaturwissenschaft; 55) Bussmann, Hadumod: Lexikon der Sprachwissenschaft. Stuttgart: Kröner, Cooper, Richard P.: Head-driven Phrase Structure Grammar. In: Brown, Edward Keith: Concise encyclopedia of syntactic theories. Oxford: Pergamon, Pollard, Carl und Sag, Ivan A.: Head-driven Phrase Structure Grammar. Chicago: The University of Chicago Press, Sag, Ivan A. und Wasow, Thomas: Syntactic Theory: A Formal Introduction. Chicago: The University of Chicago Press, Vorlesungen / Skripts Schneider, Gerold: Formale Grammatiken und Syntaxanalyse. Wintersemester 1999/2000. Volk, Martin: Formale Grammatiken und Syntaxanalyse. Wintersemester 1998/

38 homepages (mit Beiträgen von Bob Carpenter, Ivan Sag und Hans Uszkoreit) 38

Übungsaufgaben. Eine kontextfreie Grammatik lässt sich formal als Quadrupel darstellen: D : der, das N : Hund, Kaninchen V : sieht, beißt

Universität Bielefeld 25. Juni 2006 Fakultät für Linguistik und Literaturwissenschaft Formale Methoden der Linguistik III Veranstalter: Dieter Metzing Sommersemester 2006 Übungsaufgaben 1. (a) Welche Bestandteile

Universität Bielefeld 25. Juni 2006 Fakultät für Linguistik und Literaturwissenschaft Formale Methoden der Linguistik III Veranstalter: Dieter Metzing Sommersemester 2006 Übungsaufgaben 1. (a) Welche Bestandteile

Practical Grammar Engineering Using HPSG 2.Tag. Frederik Fouvry, Petter Haugereid, Valia Kordoni, Melanie Siegel

Practical Grammar Engineering Using HPSG 2.Tag Frederik Fouvry, Petter Haugereid, Valia Kordoni, Melanie Siegel Inhalt Matrix Differenzlisten Debugging (Demo, Frederik) Die LinGO Grammar Matrix Ein Nachteil

Practical Grammar Engineering Using HPSG 2.Tag Frederik Fouvry, Petter Haugereid, Valia Kordoni, Melanie Siegel Inhalt Matrix Differenzlisten Debugging (Demo, Frederik) Die LinGO Grammar Matrix Ein Nachteil

Algorithmen und Formale Sprachen

Algorithmen und Formale Sprachen Algorithmen und formale Sprachen Formale Sprachen und Algorithmen Formale Sprachen und formale Algorithmen (formale (Sprachen und Algorithmen)) ((formale Sprachen) und

Algorithmen und Formale Sprachen Algorithmen und formale Sprachen Formale Sprachen und Algorithmen Formale Sprachen und formale Algorithmen (formale (Sprachen und Algorithmen)) ((formale Sprachen) und

Syntax - Das Berechnen syntaktischer Strukturen beim menschlichen Sprachverstehen (Fortsetzung)

Syntax - Das Berechnen syntaktischer Strukturen beim menschlichen Sprachverstehen (Fortsetzung) Markus Bader 9. Februar 2004 Inhaltsverzeichnis 4 Übertragung ins e 1 4.3 Bewegung und Satztyp................................

Syntax - Das Berechnen syntaktischer Strukturen beim menschlichen Sprachverstehen (Fortsetzung) Markus Bader 9. Februar 2004 Inhaltsverzeichnis 4 Übertragung ins e 1 4.3 Bewegung und Satztyp................................

Teil II: Phrasen und Phrasenstruktur

Teil II: Phrasen und Phrasenstruktur Übersicht: Grammatische Funktionen Kategorien Konstituenten & Strukturbäume Konstituententest Endozentrizität 1 Einfacher Satzbau Drei allgemeine Grundfragen der Syntax:

Teil II: Phrasen und Phrasenstruktur Übersicht: Grammatische Funktionen Kategorien Konstituenten & Strukturbäume Konstituententest Endozentrizität 1 Einfacher Satzbau Drei allgemeine Grundfragen der Syntax:

Formale Methoden 1. Gerhard Jäger 12. Dezember Uni Bielefeld, WS 2007/2008 1/22

1/22 Formale Methoden 1 Gerhard Jäger Gerhard.Jaeger@uni-bielefeld.de Uni Bielefeld, WS 2007/2008 12. Dezember 2007 2/22 Bäume Baumdiagramme Ein Baumdiagramm eines Satzes stellt drei Arten von Information

1/22 Formale Methoden 1 Gerhard Jäger Gerhard.Jaeger@uni-bielefeld.de Uni Bielefeld, WS 2007/2008 12. Dezember 2007 2/22 Bäume Baumdiagramme Ein Baumdiagramm eines Satzes stellt drei Arten von Information

Einführung in die Sprachwissenschaft des Deutschen. Syntax IV. PD Dr. Alexandra Zepter

Einführung in die Sprachwissenschaft des Deutschen Syntax IV PD Dr. Alexandra Zepter Überblick Syntax Fokus auf linearer Ordnung: Sprachtypen, Topologisches Feldermodell Fokus auf hierarchischer Ordnung:

Einführung in die Sprachwissenschaft des Deutschen Syntax IV PD Dr. Alexandra Zepter Überblick Syntax Fokus auf linearer Ordnung: Sprachtypen, Topologisches Feldermodell Fokus auf hierarchischer Ordnung:

HPSG. Referat zu dem Thema Kongruenz im Englischen Von Anja Nerstheimer

HPSG Referat zu dem Thema Kongruenz im Englischen Von Anja Nerstheimer Gliederung Einleitung Kongruenz Allgemein Zwei Theorien der Kongruenz Probleme bei ableitungsbasierenden Kongruenztheorien Wie syntaktisch

HPSG Referat zu dem Thema Kongruenz im Englischen Von Anja Nerstheimer Gliederung Einleitung Kongruenz Allgemein Zwei Theorien der Kongruenz Probleme bei ableitungsbasierenden Kongruenztheorien Wie syntaktisch

1. Stellen Sie die Konstituentenstruktur der folgenden Sätze als Baumdiagramme dar:

1. Stellen Sie die Konstituentenstruktur der folgenden Sätze als Baumdiagramme dar: 1. Die Überschwemmungen hinterließen ernorme Schäden. 2. Der amtierende Bundeskanzler verzichtet auf eine erneute Kandidatur.

1. Stellen Sie die Konstituentenstruktur der folgenden Sätze als Baumdiagramme dar: 1. Die Überschwemmungen hinterließen ernorme Schäden. 2. Der amtierende Bundeskanzler verzichtet auf eine erneute Kandidatur.

1 Darstellung von Modalverben in einschlägigen Grammatiken am Beispiel von Eisenberg (1989) und Engel (1988)

Textmuster Daniel Händel 2003-2015 (daniel.haendel@rub.de) 1 5 1 Darstellung von Modalverben in einschlägigen Grammatiken am Beispiel von Eisenberg (1989) und Engel (1988) Zur Klassifizierung beziehungsweise

Textmuster Daniel Händel 2003-2015 (daniel.haendel@rub.de) 1 5 1 Darstellung von Modalverben in einschlägigen Grammatiken am Beispiel von Eisenberg (1989) und Engel (1988) Zur Klassifizierung beziehungsweise

Fragen zum Nachdenken: Wie könnte man das Fehlen eines Attribut-Wertes interpretieren?

Attribut-Werte-Paare Eine Eigenschaft kann beschrieben werden durch ein Paar [a,w]. Dabei bezeichnet a das Attribut und w den konkreten Wert aus dem Wertebereich W a des Attributs. Die Eigenschaften eines

Attribut-Werte-Paare Eine Eigenschaft kann beschrieben werden durch ein Paar [a,w]. Dabei bezeichnet a das Attribut und w den konkreten Wert aus dem Wertebereich W a des Attributs. Die Eigenschaften eines

Syntax Phrasenstruktur und Satzglieder

Syntax Phrasenstruktur und Satzglieder Sätze und ihre Bestandteile haben eine hierarchische Struktur. Die Bestandteile eines Satzes (Konstituenten) bestehen aus geordneten Wortfolgen, die ihrerseits wieder

Syntax Phrasenstruktur und Satzglieder Sätze und ihre Bestandteile haben eine hierarchische Struktur. Die Bestandteile eines Satzes (Konstituenten) bestehen aus geordneten Wortfolgen, die ihrerseits wieder

Fabian Heck Perlmutter & Soames Beethovenstr. 15, Raum Sommmersemester 2007

Transformationsgrammatik der 60er/70er Fabian Heck Perlmutter & Soames 1979 Institut für Linguistik Dienstag, 11h15-12h45 Universität Leipzig Beethovenstr. 15, Raum 1.516 Sommmersemester 2007 14. Regelordnungen

Transformationsgrammatik der 60er/70er Fabian Heck Perlmutter & Soames 1979 Institut für Linguistik Dienstag, 11h15-12h45 Universität Leipzig Beethovenstr. 15, Raum 1.516 Sommmersemester 2007 14. Regelordnungen

Vorlesung I: Einführung in die Syntaxtheorie

G. Schneider: Formale Grammatiken und Syntaxanalyse. 1. Vorlesung: Einführung 1 Vorlesung I: Einführung in die Syntaxtheorie Dozent: Gerold Schneider Grammar writing is much more difficult than rule writing.

G. Schneider: Formale Grammatiken und Syntaxanalyse. 1. Vorlesung: Einführung 1 Vorlesung I: Einführung in die Syntaxtheorie Dozent: Gerold Schneider Grammar writing is much more difficult than rule writing.

Einführung in die Computerlinguistik

Einführung in die Computerlinguistik Syntax II WS 2011/2012 Manfred Pinkal Geschachtelte Strukturen in natürlicher Sprache [ der an computerlinguistischen Fragestellungen interessierte Student im ersten

Einführung in die Computerlinguistik Syntax II WS 2011/2012 Manfred Pinkal Geschachtelte Strukturen in natürlicher Sprache [ der an computerlinguistischen Fragestellungen interessierte Student im ersten

Centrum für Informations- und Sprachverarbeitung Uni München Repetitorium ZP Sommersemester 09. Syntax. Alla Shashkina

Syntax Alla Shashkina Was ist Syntax? Satzlehre System von Regeln, die beschreiben, wie aus einem Inventar von Grundelementen (Morphemen, Wörtern, Satzgliedern) durch spezifische syntaktische Mittel (Morphologische

Syntax Alla Shashkina Was ist Syntax? Satzlehre System von Regeln, die beschreiben, wie aus einem Inventar von Grundelementen (Morphemen, Wörtern, Satzgliedern) durch spezifische syntaktische Mittel (Morphologische

Syntax. Ending Khoerudin Deutschabteilung FPBS UPI

Syntax Ending Khoerudin Deutschabteilung FPBS UPI Traditionale Syntaxanalyse Was ist ein Satz? Syntax: ein System von Regeln, nach denen aus einem Grundinventar kleinerer Einheiten (Wörter und Wortgruppen)

Syntax Ending Khoerudin Deutschabteilung FPBS UPI Traditionale Syntaxanalyse Was ist ein Satz? Syntax: ein System von Regeln, nach denen aus einem Grundinventar kleinerer Einheiten (Wörter und Wortgruppen)

Einführung in die Sprachwissenschaft -Tutorium-

Ruprecht-Karls-Universität Heidelberg Seminar für Computerlinguistik Wintersemester 2010/2011 Einführung in die Sprachwissenschaft -Tutorium- Dienstag, 16.00 18.00 Uhr Seminarraum 10 Aufgaben Kapitel 1

Ruprecht-Karls-Universität Heidelberg Seminar für Computerlinguistik Wintersemester 2010/2011 Einführung in die Sprachwissenschaft -Tutorium- Dienstag, 16.00 18.00 Uhr Seminarraum 10 Aufgaben Kapitel 1

Syntax 6: Rektion und Bindung Zwischen dem Kopf und seinen Argumenten besteht ein Abhängigkeitsverhältnis:

Einführung in die Sprachwissenschaft Jan Eden Syntax 6: Rektion und Bindung Zwischen dem Kopf und seinen Argumenten besteht ein Abhängigkeitsverhältnis: (1) a. Er bezichtigt seinen Kompagnon des Mordes.

Einführung in die Sprachwissenschaft Jan Eden Syntax 6: Rektion und Bindung Zwischen dem Kopf und seinen Argumenten besteht ein Abhängigkeitsverhältnis: (1) a. Er bezichtigt seinen Kompagnon des Mordes.

Grammatiken. Eine Grammatik G mit Alphabet Σ besteht aus: Variablen V. Startsymbol S V. Kurzschreibweise G = (V, Σ, P, S)

Grammatiken Eine Grammatik G mit Alphabet Σ besteht aus: Variablen V Startsymbol S V Produktionen P ( (V Σ) \ Σ ) (V Σ) Kurzschreibweise G = (V, Σ, P, S) Schreibweise für Produktion (α, β) P: α β 67 /

Grammatiken Eine Grammatik G mit Alphabet Σ besteht aus: Variablen V Startsymbol S V Produktionen P ( (V Σ) \ Σ ) (V Σ) Kurzschreibweise G = (V, Σ, P, S) Schreibweise für Produktion (α, β) P: α β 67 /

Einführung Computerlinguistik. Konstituentensyntax II

Einführung Computerlinguistik Konstituentensyntax II Hinrich Schütze & Robert Zangenfeind Centrum für Informations- und Sprachverarbeitung, LMU München 2013-11-18 Schütze & Zangenfeind: Konstituentensyntax

Einführung Computerlinguistik Konstituentensyntax II Hinrich Schütze & Robert Zangenfeind Centrum für Informations- und Sprachverarbeitung, LMU München 2013-11-18 Schütze & Zangenfeind: Konstituentensyntax

Parsing mit NLTK. Parsing mit NLTK. Parsing mit NLTK. Parsing mit NLTK. Beispiel: eine kleine kontextfreie Grammatik (cf. [BKL09], Ch. 8.

![Parsing mit NLTK. Parsing mit NLTK. Parsing mit NLTK. Parsing mit NLTK. Beispiel: eine kleine kontextfreie Grammatik (cf. [BKL09], Ch. 8. Parsing mit NLTK. Parsing mit NLTK. Parsing mit NLTK. Parsing mit NLTK. Beispiel: eine kleine kontextfreie Grammatik (cf. [BKL09], Ch. 8.](/thumbs/39/18970986.jpg) Gliederung Natürlichsprachliche Systeme I D. Rösner Institut für Wissens- und Sprachverarbeitung Fakultät für Informatik Otto-von-Guericke Universität Magdeburg 1 WS 2011/12, 26. Oktober 2011, c 2010-2012

Gliederung Natürlichsprachliche Systeme I D. Rösner Institut für Wissens- und Sprachverarbeitung Fakultät für Informatik Otto-von-Guericke Universität Magdeburg 1 WS 2011/12, 26. Oktober 2011, c 2010-2012

Syntax II. Gereon Müller Institut für Linguistik 4. November Typeset by FoilTEX

Syntax II Gereon Müller Institut für Linguistik heck@uni-leipzig.de gereon.mueller@uni-leipzig.de 4. November 2014 Typeset by FoilTEX [A] Kasus, 4. Teil [1] Inhärente vs. strukturelle Kasus: Fanselow (1999)

Syntax II Gereon Müller Institut für Linguistik heck@uni-leipzig.de gereon.mueller@uni-leipzig.de 4. November 2014 Typeset by FoilTEX [A] Kasus, 4. Teil [1] Inhärente vs. strukturelle Kasus: Fanselow (1999)

Konstruktionsgrammatik

Konstruktionsgrammatik Allgemein: - Auch Construction Grammar (CxG) genannt - Gehört wie LFG und HPSG zur West-Coast Linguistik - Sprache besteht zu großen Teilen aus komplexen Einheiten Lassen sich mit

Konstruktionsgrammatik Allgemein: - Auch Construction Grammar (CxG) genannt - Gehört wie LFG und HPSG zur West-Coast Linguistik - Sprache besteht zu großen Teilen aus komplexen Einheiten Lassen sich mit

Gliederung. Das TIGER-Korpus: Annotation und Exploration. TIGER-Korpus. 1. TIGER-Korpus. entstanden im Projekt TIGER (1999 heute) beteiligte Institute

Das TIGER-Korpus: Annotation und Exploration Stefanie Dipper Forschungskolloquium Korpuslinguistik, 11.11.03 Gliederung 1. TIGER-Korpus 2. Annotation 3. Visualisierung 4. Suche, Retrieval 5. Demo 6. Repräsentation

Das TIGER-Korpus: Annotation und Exploration Stefanie Dipper Forschungskolloquium Korpuslinguistik, 11.11.03 Gliederung 1. TIGER-Korpus 2. Annotation 3. Visualisierung 4. Suche, Retrieval 5. Demo 6. Repräsentation

Lange Abhängigkeiten in Brosziewski-Derivationen

Lange Abhängigkeiten in Brosziewski-Derivationen (UiL-OTS, Universiteit Utrecht) C.Unger@uu.nl GGS, Leipzig, 22. 24. Mai 2009 > Ziel Ziel W-Bewegung in einer derivationellen Syntax mit strikt lokalen Operationen,

Lange Abhängigkeiten in Brosziewski-Derivationen (UiL-OTS, Universiteit Utrecht) C.Unger@uu.nl GGS, Leipzig, 22. 24. Mai 2009 > Ziel Ziel W-Bewegung in einer derivationellen Syntax mit strikt lokalen Operationen,

Semesterplan. Generative Grammatik. Syntactic Structures Aspects Prinzipien und Parameter. HS 06 Zifonun, Gisela

Deutschen Theorien Aus Zeitgründen wird nur die an Noam Chomsky (geb. 7.12.1928 in Philadelphia, Professor am MIT) orientierte so genannte in ihren verschiedenen Entwicklungsstufen behandelt. Neuerungen

Deutschen Theorien Aus Zeitgründen wird nur die an Noam Chomsky (geb. 7.12.1928 in Philadelphia, Professor am MIT) orientierte so genannte in ihren verschiedenen Entwicklungsstufen behandelt. Neuerungen

5 Benutzungsoberfläche

5 Mit Ausnahme der in Kapitel 4.1 beschriebenen ÜNs wurde das Verfahren zur Transformation von Hauptansprüchen als JAVA-Anwendung implementiert. Die Anwendung, genannt ClaimTransformer, umfasst zusätzlich

5 Mit Ausnahme der in Kapitel 4.1 beschriebenen ÜNs wurde das Verfahren zur Transformation von Hauptansprüchen als JAVA-Anwendung implementiert. Die Anwendung, genannt ClaimTransformer, umfasst zusätzlich

Objektorientierte Programmierung. Kapitel 3: Syntaxdiagramme und Grammatikregeln

Stefan Brass: OOP (Java), 3. Syntaxdiagramme und Grammatikregeln 1/32 Objektorientierte Programmierung Kapitel 3: Syntaxdiagramme und Grammatikregeln Stefan Brass Martin-Luther-Universität Halle-Wittenberg

Stefan Brass: OOP (Java), 3. Syntaxdiagramme und Grammatikregeln 1/32 Objektorientierte Programmierung Kapitel 3: Syntaxdiagramme und Grammatikregeln Stefan Brass Martin-Luther-Universität Halle-Wittenberg

Frage 8.3. Wozu dienen Beweise im Rahmen einer mathematischen (Lehramts-)Ausbildung?

8 Grundsätzliches zu Beweisen Frage 8.3. Wozu dienen Beweise im Rahmen einer mathematischen (Lehramts-)Ausbildung? ˆ Mathematik besteht nicht (nur) aus dem Anwenden auswendig gelernter Schemata. Stattdessen

8 Grundsätzliches zu Beweisen Frage 8.3. Wozu dienen Beweise im Rahmen einer mathematischen (Lehramts-)Ausbildung? ˆ Mathematik besteht nicht (nur) aus dem Anwenden auswendig gelernter Schemata. Stattdessen

Wort. nicht flektierbar. flektierbar. nach Person, Numerus, Modus, Tempus, Genus verbi flektiert. nach Genus, Kasus, Numerus flektiert

Wort flektierbar nicht flektierbar nach Person, Numerus, Modus, Tempus, Genus verbi flektiert genufest nach Genus, Kasus, Numerus flektiert genusveränderlich komparierbar nicht komparierbar Verb Substantiv

Wort flektierbar nicht flektierbar nach Person, Numerus, Modus, Tempus, Genus verbi flektiert genufest nach Genus, Kasus, Numerus flektiert genusveränderlich komparierbar nicht komparierbar Verb Substantiv

Sprachkontrastive Darstellung Deutsch-Türkisch

Germanistik Nuran Aksoy Sprachkontrastive Darstellung Deutsch-Türkisch Studienarbeit Freie Universität Berlin Wintersemester 2003/2004 Fachbereich Philosophie und Geisteswissenschaften: Fächergruppe deutsche

Germanistik Nuran Aksoy Sprachkontrastive Darstellung Deutsch-Türkisch Studienarbeit Freie Universität Berlin Wintersemester 2003/2004 Fachbereich Philosophie und Geisteswissenschaften: Fächergruppe deutsche

3. Phrasenstruktur und Merkmale 2

.1. WIEDERHOLUNG. Phrasenstruktur und Merkmale An welchen Eigenschaften erkennt man den Kopf einer Phrase? Was besagt das Thetakriterium? Was sind interpretierbare und uninterpretierbare Merkmale? Was

.1. WIEDERHOLUNG. Phrasenstruktur und Merkmale An welchen Eigenschaften erkennt man den Kopf einer Phrase? Was besagt das Thetakriterium? Was sind interpretierbare und uninterpretierbare Merkmale? Was

Am Anfang war das Wort!

Am Anfang war das Wort! Was ist Morphologie? Der Begriff Morphologie wurde 1796 von Johann Wolfgang von Goethe in einer Tagebuchaufzeichnung für eine neue Wissenschaft geprägt,, die sich mit den Gestaltungsgesetzen

Am Anfang war das Wort! Was ist Morphologie? Der Begriff Morphologie wurde 1796 von Johann Wolfgang von Goethe in einer Tagebuchaufzeichnung für eine neue Wissenschaft geprägt,, die sich mit den Gestaltungsgesetzen

Grundkurs Linguistik - Syntax

Grundkurs Linguistik - Syntax Jens Fleischhauer fleischhauer@phil.uni-duesseldorf.de Universität Düsseldorf; Abteilung für Allgemeine Sprachwissenschaft 19.11.2015; WS 2015/2016 1 / 24 Jens Fleischhauer

Grundkurs Linguistik - Syntax Jens Fleischhauer fleischhauer@phil.uni-duesseldorf.de Universität Düsseldorf; Abteilung für Allgemeine Sprachwissenschaft 19.11.2015; WS 2015/2016 1 / 24 Jens Fleischhauer

Einführung in die Linguistik, Teil 4

Einführung in die Linguistik, Teil 4 Syntax - Das Berechnen syntaktischer Strukturen beim menschlichen Sprachverstehen Markus Bader, Frans Plank, Henning Reetz, Björn Wiemer Einführung in die Linguistik,

Einführung in die Linguistik, Teil 4 Syntax - Das Berechnen syntaktischer Strukturen beim menschlichen Sprachverstehen Markus Bader, Frans Plank, Henning Reetz, Björn Wiemer Einführung in die Linguistik,

Syntaktische Bäume. Syntaktische Bäume: Prinzipien. Köpfe in Syntax vs. Morphologie CP! C S VP! V CP PP! P NP. S! NP VP VP! V (NP) PP* NP!

Einführung in die Linguistik Butt / Eulitz / Wiemer Di. 12:15-13:45 Do.! 12:15-13:45 Fr.! 12:15-13:45 Syntax nfos etc. http://ling.uni-konstanz.de => Lehre Einführung in die Linguistik Syntaktische Bäume

Einführung in die Linguistik Butt / Eulitz / Wiemer Di. 12:15-13:45 Do.! 12:15-13:45 Fr.! 12:15-13:45 Syntax nfos etc. http://ling.uni-konstanz.de => Lehre Einführung in die Linguistik Syntaktische Bäume

Kapitel 2: Formale Sprachen Gliederung. 0. Grundbegriffe 1. Endliche Automaten 2. Formale Sprachen 3. Berechnungstheorie 4. Komplexitätstheorie

Gliederung 0. Grundbegriffe 1. Endliche Automaten 2. Formale Sprachen 3. Berechnungstheorie 4. Komplexitätstheorie 2.1. 2.2. Reguläre Sprachen 2.3. Kontextfreie Sprachen 2/1, Folie 1 2015 Prof. Steffen

Gliederung 0. Grundbegriffe 1. Endliche Automaten 2. Formale Sprachen 3. Berechnungstheorie 4. Komplexitätstheorie 2.1. 2.2. Reguläre Sprachen 2.3. Kontextfreie Sprachen 2/1, Folie 1 2015 Prof. Steffen

Einführung in die Informatik I (autip)

Einführung in die Informatik I (autip) Dr. Stefan Lewandowski Fakultät 5: Informatik, Elektrotechnik und Informationstechnik Abteilung Formale Konzepte Universität Stuttgart 24. Oktober 2007 Was Sie bis

Einführung in die Informatik I (autip) Dr. Stefan Lewandowski Fakultät 5: Informatik, Elektrotechnik und Informationstechnik Abteilung Formale Konzepte Universität Stuttgart 24. Oktober 2007 Was Sie bis

Entwicklung eines E-Learning Topic-Map Rahmenwerks

Institut für Betriebssysteme und Rechnerverbund der TU Braunschweig Verteilte Systeme, Prof. Dr. Fischer Entwicklung eines Topic-Map Rahmenwerks Betreuer: Martin Gutbrod Bearbeitet von: Yichen Yu Gliederung

Institut für Betriebssysteme und Rechnerverbund der TU Braunschweig Verteilte Systeme, Prof. Dr. Fischer Entwicklung eines Topic-Map Rahmenwerks Betreuer: Martin Gutbrod Bearbeitet von: Yichen Yu Gliederung

Kapitel DB:IV (Fortsetzung)

Kapitel DB:IV (Fortsetzung) IV. Logischer Datenbankentwurf mit dem relationalen Modell Das relationale Modell Integritätsbedingungen Umsetzung ER-Schema in relationales Schema DB:IV-45 Relational Design

Kapitel DB:IV (Fortsetzung) IV. Logischer Datenbankentwurf mit dem relationalen Modell Das relationale Modell Integritätsbedingungen Umsetzung ER-Schema in relationales Schema DB:IV-45 Relational Design

Arten und Typen von Grammatiken

Arten und Typen von Grammatiken 19.04.2010 Helbig (2001) 2 Was ist Grammatik? 3 Begriff Grammatik bezieht sich auf drei Sachverhalte a) die der Sprache selbst inne wohnende Regeln, unabhängig von deren

Arten und Typen von Grammatiken 19.04.2010 Helbig (2001) 2 Was ist Grammatik? 3 Begriff Grammatik bezieht sich auf drei Sachverhalte a) die der Sprache selbst inne wohnende Regeln, unabhängig von deren

Das Kompositionalitätsprinzip

Das Kompositionalitätsprinzip (Version 1.0) Seminar Kompositionalität, 2005 1 Das Kompositionalitätsprinzip (Version 1.0) Die Bedeutung eines komplexen Ausdrucks ist durch die Bedeutung seiner Teile bestimmt

Das Kompositionalitätsprinzip (Version 1.0) Seminar Kompositionalität, 2005 1 Das Kompositionalitätsprinzip (Version 1.0) Die Bedeutung eines komplexen Ausdrucks ist durch die Bedeutung seiner Teile bestimmt

Problemreduktion durch Transformation am Beispiel des. Erweiterten Euklidschen Algorithmus

Problemreduktion durch Transformation am Beispiel des Erweiterten Euklidschen Algorithmus Wolfgang Windsteiger JKU Linz, A 4040 Linz, Austria Kurzfassung Transformation beschreibt im Wesentlichen die algorithmische

Problemreduktion durch Transformation am Beispiel des Erweiterten Euklidschen Algorithmus Wolfgang Windsteiger JKU Linz, A 4040 Linz, Austria Kurzfassung Transformation beschreibt im Wesentlichen die algorithmische

Formale Methoden III - Tutorium

Formale Methoden III - Tutorium Daniel Jettka 19.06.06 Inhaltsverzeichnis 1. Logische Eigenschaften von Merkmalsstrukturen 1. Logische Eigenschaften von MS Ausgangspunkt: Unterscheidung von: Linguistische

Formale Methoden III - Tutorium Daniel Jettka 19.06.06 Inhaltsverzeichnis 1. Logische Eigenschaften von Merkmalsstrukturen 1. Logische Eigenschaften von MS Ausgangspunkt: Unterscheidung von: Linguistische

Im allerersten Unterabschnitt wollen wir uns mit einer elementaren Struktur innerhalb der Mathematik beschäftigen: Mengen.

Kapitel 1 - Mathematische Grundlagen Seite 1 1 - Mengen Im allerersten Unterabschnitt wollen wir uns mit einer elementaren Struktur innerhalb der Mathematik beschäftigen: Mengen. Definition 1.1 (G. Cantor.

Kapitel 1 - Mathematische Grundlagen Seite 1 1 - Mengen Im allerersten Unterabschnitt wollen wir uns mit einer elementaren Struktur innerhalb der Mathematik beschäftigen: Mengen. Definition 1.1 (G. Cantor.

SQL. SQL SELECT Anweisung SQL-SELECT SQL-SELECT

SQL SQL SELECT Anweisung Mit der SQL SELECT-Anweisung werden Datenwerte aus einer oder mehreren Tabellen einer Datenbank ausgewählt. Das Ergebnis der Auswahl ist erneut eine Tabelle, die sich dynamisch

SQL SQL SELECT Anweisung Mit der SQL SELECT-Anweisung werden Datenwerte aus einer oder mehreren Tabellen einer Datenbank ausgewählt. Das Ergebnis der Auswahl ist erneut eine Tabelle, die sich dynamisch

Das Aktantenpotenzial beschreibt die Möglichkeit eines Verbs andere Wörter an

1 2 Das Aktantenpotenzial beschreibt die Möglichkeit eines Verbs andere Wörter an sich zu binden, nämlich die Aktanten. Aktant ist demzufolge ein Begriff, der für die Valenzpartner eines Verbs auf der

1 2 Das Aktantenpotenzial beschreibt die Möglichkeit eines Verbs andere Wörter an sich zu binden, nämlich die Aktanten. Aktant ist demzufolge ein Begriff, der für die Valenzpartner eines Verbs auf der

Kontextsensitive Sprachen

Kontextsensitive Sprachen Standardbeispiel: {anbncn} S a b c S a A b B c c B A B b c B b b A A b a A a a Im Bereich der natürlichen Sprachen gibt es zahlreiche kontextsensitive Phänomene in der Semantik

Kontextsensitive Sprachen Standardbeispiel: {anbncn} S a b c S a A b B c c B A B b c B b b A A b a A a a Im Bereich der natürlichen Sprachen gibt es zahlreiche kontextsensitive Phänomene in der Semantik

Einführung in die Logik

Einführung in die Logik Prof. Dr. Ansgar Beckermann Wintersemester 2001/2 Allgemeines vorab Wie es abläuft Vorlesung (Grundlage: Ansgar Beckermann. Einführung in die Logik. (Sammlung Göschen Bd. 2243)

Einführung in die Logik Prof. Dr. Ansgar Beckermann Wintersemester 2001/2 Allgemeines vorab Wie es abläuft Vorlesung (Grundlage: Ansgar Beckermann. Einführung in die Logik. (Sammlung Göschen Bd. 2243)

3. Relationen Erläuterungen und Schreibweisen

3. Relationen Eine Relation ist allgemein eine Beziehung, die zwischen Dingen bestehen kann. Relationen im Sinne der Mathematik sind ausschließlich diejenigen Beziehungen, bei denen stets klar ist, ob

3. Relationen Eine Relation ist allgemein eine Beziehung, die zwischen Dingen bestehen kann. Relationen im Sinne der Mathematik sind ausschließlich diejenigen Beziehungen, bei denen stets klar ist, ob

EINFÜHRUNG IN DIE THEORETISCHE INFORMATIK

EINFÜHRUNG IN DIE THEORETISCHE INFORMATIK Prof. Dr. Klaus Ambos-Spies Sommersemester 2011 17. DIE CHOMSKY-HIERARCHIE Theoretische Informatik (SoSe 2011) 17. Die Chomsky-Hierarchie 1 / 15 Einleitung Die

EINFÜHRUNG IN DIE THEORETISCHE INFORMATIK Prof. Dr. Klaus Ambos-Spies Sommersemester 2011 17. DIE CHOMSKY-HIERARCHIE Theoretische Informatik (SoSe 2011) 17. Die Chomsky-Hierarchie 1 / 15 Einleitung Die

Kontextfreie Sprachen

Kontextfreie Sprachen Bei regulären (=Typ 3-) Grammatikregeln stehen maximal ein Terminal- und ein Nichtterminalsymbol auf der rechten Seite. Dadurch läßt sich lediglich die Abfolge der Terminalzeichen

Kontextfreie Sprachen Bei regulären (=Typ 3-) Grammatikregeln stehen maximal ein Terminal- und ein Nichtterminalsymbol auf der rechten Seite. Dadurch läßt sich lediglich die Abfolge der Terminalzeichen

EF Semantik: Musterlösung zu Aufgabenblatt 2

EF Semantik: Musterlösung zu Aufgabenblatt 2 Magdalena Schwager magdalena@schwager.at Sommersemester 2010, Universität Wien Lösen Sie folgende Aufgaben (1)-(4) und geben Sie sie zusammengetackert bei András,

EF Semantik: Musterlösung zu Aufgabenblatt 2 Magdalena Schwager magdalena@schwager.at Sommersemester 2010, Universität Wien Lösen Sie folgende Aufgaben (1)-(4) und geben Sie sie zusammengetackert bei András,

Fersentalerisch: SVO SOV?

Linguistica tedesca- LS 44S - A.A. 07/08 - Das Fersentalerische, eine deutsche Sprachinsel in Norditalien 1 Birgit Alber, 7.4. 2008 Fersentalerisch: SVO SOV? SVO - Sprachen: Subjekt Verb Objekt SOV Sprachen:

Linguistica tedesca- LS 44S - A.A. 07/08 - Das Fersentalerische, eine deutsche Sprachinsel in Norditalien 1 Birgit Alber, 7.4. 2008 Fersentalerisch: SVO SOV? SVO - Sprachen: Subjekt Verb Objekt SOV Sprachen:

Empfehlenswerte Referenzen

Wenn Google etwas nicht finden kann, fragen sie Jack Bauer. ("Fakten über Jack Bauer") Inhalt Empfehlenswerte Referenzen...1 0 Wozu reguläre Ausdrücke?...1 1 Die Elemente regulärer Ausdrücke...2 2 Ein

Wenn Google etwas nicht finden kann, fragen sie Jack Bauer. ("Fakten über Jack Bauer") Inhalt Empfehlenswerte Referenzen...1 0 Wozu reguläre Ausdrücke?...1 1 Die Elemente regulärer Ausdrücke...2 2 Ein

1. Gruppen. 1. Gruppen 7

1. Gruppen 7 1. Gruppen Wie schon in der Einleitung erläutert wollen wir uns in dieser Vorlesung mit Mengen beschäftigen, auf denen algebraische Verknüpfungen mit gewissen Eigenschaften definiert sind.

1. Gruppen 7 1. Gruppen Wie schon in der Einleitung erläutert wollen wir uns in dieser Vorlesung mit Mengen beschäftigen, auf denen algebraische Verknüpfungen mit gewissen Eigenschaften definiert sind.

E. AUSBAU DER INFINITESIMALRECHNUNG 17. UMKEHRFUNKTIONEN (INVERSE FUNCTION)

160 Dieses Skript ist ein Auszug mit Lücken aus Einführung in die mathematische Behandlung der Naturwissenschaften I von Hans Heiner Storrer, Birkhäuser Skripten. Als StudentIn sollten Sie das Buch auch

160 Dieses Skript ist ein Auszug mit Lücken aus Einführung in die mathematische Behandlung der Naturwissenschaften I von Hans Heiner Storrer, Birkhäuser Skripten. Als StudentIn sollten Sie das Buch auch

Sprachen und Programmiersprachen

Sprachen und Programmiersprachen Natürliche Sprachen versus Programmiersprachen / Spezifikationssprachen Syntax legt die grammatikalische Korrektheit fest. Semantik legt die Bedeutung von syntaktisch korrekten

Sprachen und Programmiersprachen Natürliche Sprachen versus Programmiersprachen / Spezifikationssprachen Syntax legt die grammatikalische Korrektheit fest. Semantik legt die Bedeutung von syntaktisch korrekten

Vorsemesterkurs Informatik

Vorsemesterkurs Informatik Vorsemesterkurs Informatik Mario Holldack WS2015/16 30. September 2015 Vorsemesterkurs Informatik 1 Einleitung 2 Aussagenlogik 3 Mengen Vorsemesterkurs Informatik > Einleitung

Vorsemesterkurs Informatik Vorsemesterkurs Informatik Mario Holldack WS2015/16 30. September 2015 Vorsemesterkurs Informatik 1 Einleitung 2 Aussagenlogik 3 Mengen Vorsemesterkurs Informatik > Einleitung

Logic in a Nutshell. Christian Liguda

Logic in a Nutshell Christian Liguda Quelle: Kastens, Uwe und Büning, Hans K., Modellierung: Grundlagen und formale Methoden, 2009, Carl Hanser Verlag Übersicht Logik - Allgemein Aussagenlogik Modellierung

Logic in a Nutshell Christian Liguda Quelle: Kastens, Uwe und Büning, Hans K., Modellierung: Grundlagen und formale Methoden, 2009, Carl Hanser Verlag Übersicht Logik - Allgemein Aussagenlogik Modellierung

Kapitel 4: Syntaxdiagramme und Grammatikregeln

4. Syntaxdiagramme und Grammatikregeln 4-1 Objektorientierte Programmierung (Winter 2006/2007) Kapitel 4: Syntaxdiagramme und Grammatikregeln Syntaxdiagramme Grammatikregeln (kontextfrei) Beispiele: Lexikalische

4. Syntaxdiagramme und Grammatikregeln 4-1 Objektorientierte Programmierung (Winter 2006/2007) Kapitel 4: Syntaxdiagramme und Grammatikregeln Syntaxdiagramme Grammatikregeln (kontextfrei) Beispiele: Lexikalische

Behaviorismus und Nativismus im Erstspracherwerb

Behaviorismus und Nativismus im Erstspracherwerb 13-SQM-04 (Naturwissenschaft für Querdenker) 09.07.2015 Simeon Schüz Gliederung 1. Einleitung 2. Die Behavioristische Hypothese 2.1 Grundlegende Annahmen

Behaviorismus und Nativismus im Erstspracherwerb 13-SQM-04 (Naturwissenschaft für Querdenker) 09.07.2015 Simeon Schüz Gliederung 1. Einleitung 2. Die Behavioristische Hypothese 2.1 Grundlegende Annahmen

Parsing-EinfŸhrung Ð 1

Parsing-EinfŸhrung bersicht Falsifizierbarkeit, oder: Sind Grammatiken wissenschaftlich? Grammatik, Formalismus Kontextfreie Grammatiken Ableitungen Ziel Verstehen der linguistischen Motivation Intuitives

Parsing-EinfŸhrung bersicht Falsifizierbarkeit, oder: Sind Grammatiken wissenschaftlich? Grammatik, Formalismus Kontextfreie Grammatiken Ableitungen Ziel Verstehen der linguistischen Motivation Intuitives

DGA 33 Themen der Deutschen Syntax Universität Athen, WiSe Winfried Lechner Skriptum, Teil 3 K-KOMMANDO

DGA Themen der Deutschen Syntax Universität Athen, WiSe 015-16 Winfried Lechner Skriptum, Teil K-KOMMANDO Dieser Abschnitt führt die syntaktische Beziehung des K-Kommandos ein. Es werden zudem Tests vorgestellt,

DGA Themen der Deutschen Syntax Universität Athen, WiSe 015-16 Winfried Lechner Skriptum, Teil K-KOMMANDO Dieser Abschnitt führt die syntaktische Beziehung des K-Kommandos ein. Es werden zudem Tests vorgestellt,

Terminus Sprache, Phonologie und Grammatik

Terminus Sprache, Phonologie und Grammatik Terminus Sprache Beinhaltet 4 verschiedene Bedeutungen Langage: menschliche Fähigkeit Langue: eine bestimmte Sprache, Untersuchungsgebiet der Linguistik Parole:

Terminus Sprache, Phonologie und Grammatik Terminus Sprache Beinhaltet 4 verschiedene Bedeutungen Langage: menschliche Fähigkeit Langue: eine bestimmte Sprache, Untersuchungsgebiet der Linguistik Parole:

2. Überlegen Sie, ob folgende Sprache vom gleichen Typ sind (m, n 1): Ordnen Sie die Sprachen jeweils auf der Chomsky-Hierarchie ein.

Musterlösung Übung 1 Formale Grammatiken 1. Schreiben Sie eine Grammatik für die Sprache a m b c n d m (m, n 1). Ordnen Sie die Sprache auf der Chomsky-Hierarchie ein und begründen Sie, warum (a) eine

Musterlösung Übung 1 Formale Grammatiken 1. Schreiben Sie eine Grammatik für die Sprache a m b c n d m (m, n 1). Ordnen Sie die Sprache auf der Chomsky-Hierarchie ein und begründen Sie, warum (a) eine

Grundlagen der Theoretischen Informatik Musterlösungen zu ausgewählten Übungsaufgaben